AI Community

AI 세계로의 여정을 시작하세요

최신 AI 뉴스, 트렌드, 튜토리얼을 한 곳에서 만나보세요

뉴스레터

매주 금요일, AI 트렌드를 정리해 드립니다

프

프리랜서 개발자

Anthropic API 키 없이 Claude Code 사용하기! (Ollama 로컬 모델 활용법)

Anthropic API 키 없이 Claude Code를 로컬에서 사용하는 방법은 무엇이며, 그 핵심 개념은 무엇인가? Ollama의 최신 버전이 Anthropic Message API 호환성을 지원하게 됨으로써, Anthropic API 키 없이도 Claude Code가 로컬 Ollama 서버를 통해 로컬 모델과 통신하며 작동하도록 환경을 설정하는 것이 핵심입니다. Anthropic API 키 없이 Claude Code를 로컬에서 사용하기 위한 구체적인 메커니즘/원리는 무엇인가? • **Ollama 설치 및 업그레이드 (Ollama Installation & Upgrade):** Anthropic Message API 호환성을 위해 Ollama를 반드시 0.1.14.2 이상 버전으로 업그레이드해야 합니다. 이는 Claude Code가 로컬 Ollama 서버와 통신할 수 있도록 하는 필수 조건입니다. • **Anthropic 호환 로컬 모델 다운로드 (Anthropic-Compatible Local Model Download):** `ollama pull` 명령어를 사용하여 QN3 Code, Open AgForce와 같이 툴 콜(Tool Call) 및 64K 이상의 컨텍스트 윈도우(Context Window)를 지원하는 로컬 모델을 다운로드합니다. • **Claude Code 설치 및 환경 변수 설정 (Claude Code Installation & Environment Variable Setup):** `npm install -g @anthropic-ai/claude-code` 명령어로 Claude Code를 설치한 후, `ANTHROPIC_API_KEY` 환경 변수는 임의의 값(예: `ollama` 또는 `any_value`)으로 설정하고, `ANTHROPIC_BASE_URL` 환경 변수는 `http://localhost:11434`로 설정하여 Claude Code의 API 요청이 로컬 Ollama 서버로 리디렉션되도록 합니다. • **로컬에서 Claude Code 실행 및 활용 (Running Claude Code Locally):** 환경 설정이 완료되면 `claude` 명령어를 실행하여 Claude Code를 로컬에서 구동할 수 있으며, 다운로드된 Ollama 모델을 통해 코드 생성, 채팅, 툴 콜(Tool Call) 기능 등을 수행할 수 있습니다. Python API를 통해서도 동일한 방식으로 로컬 모델과 연동하여 사용할 수 있습니다. 이 영상은 Anthropic의 강력한 AI 코딩 어시스턴트인 Claude Code를 Anthropic API 키 없이 로컬 환경에서 사용하는 혁신적인 방법을 상세히 설명합니다. 핵심은 오픈소스 LLM 프레임워크인 Ollama가 Anthropic Message API 호환성을 지원하게 된 점을 활용하는 것입니다. 이를 통해 사용자는 개인 장치에서 Claude Code를 구동하고, Anthropic의 API 호출 없이 로컬 모델(예: QN3 Code, Open AgForce)을 활용하여 코드 생성, 디버깅, 툴 콜(Tool Call) 기능 등을 수행할 수 있습니다. 영상은 Ollama 설치 및 업그레이드부터 Claude Code 설치, 그리고 핵심적인 환경 변수 설정 과정을 단계별로 안내하며, 실제 코드 생성 및 Python API 연동 예시를 통해 그 가능성을 보여줍니다. 이는 개발자들이 비용 부담 없이 강력한 AI 코딩 도구를 로컬에서 활용하고, 데이터 프라이버시를 유지하며, 다양한 실험을 수행할 수 있는 중요한 대안을 제시합니다. * **00:00 - 00:20 영상 개요 및 목표 소개 (Introduction and Goal)** * 영상은 Anthropic API 키 없이 Claude Code를 Ollama 기반의 로컬 모델로 사용하는 방법을 다룹니다. * 이를 통해 사용자는 로컬 환경에서 Claude Code를 실행할 수 있습니다. * **00:20 - 00:40 Ollama 설치 및 GPU 환경 확인 (Ollama Installation and GPU Environment Check)** * Ollama가 시스템에 설치되어 있는지 확인하는 것이 첫 번째 단계입니다. * 강사는 자신의 Ubuntu 시스템과 Nvidia RTX A6000 GPU (48GB VRAM) 환경을 보여주며, 이미 Ollama가 설치되어 있고 두 가지 모델(QN3 Code, Open AgForce)이 준비되어 있음을 언급합니다. * Ollama 설치 방법은 채널 내 다른 영상을 참고하도록 안내합니다. * **00:40 - 01:25 Ollama 버전 업그레이드의 중요성 (Importance of Ollama Version Upgrade)** * Ollama 설치 여부와 관계없이 반드시 최신 버전(0.1.14.2 이상)으로 업그레이드해야 함을 강조합니다. * 이는 Anthropic 호환성을 위한 핵심 요구사항입니다. * 업그레이드 방법은 별도의 3분짜리 영상에 정리되어 있다고 안내하며, 해당 영상을 먼저 시청하고 돌아오도록 요청합니다. * **01:25 - 01:55 Ollama 모델 준비 (Ollama Model Preparation)** * 업그레이드 후, 로컬에서 사용할 모델이 준비되었는지 확인합니다. * 만약 모델이 없다면 `ollama pull <model_name>` 명령어를 사용하여 QN3 Code 또는 Open AgForce와 같은 모델을 다운로드하도록 안내합니다. * 이 모델들은 툴 콜(Tool Call, 함수 사용 기능)을 지원해야 하며, 최소 64K 이상의 컨텍스트 윈도우(Context Window)를 가져야 한다고 강조합니다. * **01:55 - 02:15 Claude Code 설치 (Claude Code Installation)** * 다음 단계로 Claude Code를 설치합니다. * 제공된 명령어(`npm install -g @anthropic-ai/claude-code`)를 실행하여 최신 시스템에 Claude Code를 설치합니다. * **02:15 - 02:25 Anthropic 로그인 상태 확인 및 로그아웃 (Check Anthropic Login Status and Logout)** * Claude Code가 이미 설치되어 있다면, Anthropic에 로그인되어 있을 수 있으므로 반드시 로그아웃해야 한다고 주의를 줍니다. * **02:25 - 03:25 환경 변수 설정: 핵심 비결 (Environment Variable Setup: The Core Secret)** * 이제 핵심적인 환경 변수를 설정합니다. * `ANTHROPIC_API_KEY`는 `ollama`나 다른 임의의 값으로 설정합니다. (실제 Anthropic API 키가 아니어도 됩니다.) * `ANTHROPIC_BASE_URL`은 `http://localhost:11434`로 설정합니다. * 이 설정의 중요성을 설명합니다: Ollama가 이제 Anthropic 호환 메시지 API(Message API)를 지원하기 때문에, Claude Code의 API 요청이 로컬 Ollama 서버로 리디렉션되어 로컬 모델을 사용할 수 있게 됩니다. * 이것은 오랫동안 기다려온 기능이며, Ollama가 OpenAI 호환뿐만 아니라 Anthropic 호환까지 가능하게 되었다는 점을 강조합니다. * `http://localhost:11434`는 Ollama의 기본 포트이며, 만약 다른 포트를 사용한다면 해당 포트로 수정해야 한다고 덧붙입니다. * **03:25 - 03:55 Claude Code 실행 및 기본 사용 (Running Claude Code and Basic Usage)** * 환경 변수 설정 후 `claude` 명령어를 실행합니다. * 진행 여부를 묻는 메시지에 '예'라고 답하면 Claude Code가 실행됩니다. * Claude Code가 Anthropic의 테마 색상으로 실행되며, 채팅, 코드 생성, 타입 체크 오류 수정 등 다양한 작업을 수행할 수 있음을 보여줍니다. * "Hello World 프로그램을 작성해 줘" 요청을 통해 코드가 성공적으로 생성되는 것을 시연합니다. * 모델이나 Claude Code 자체의 성능 테스트는 이미 다른 영상에서 많이 다루었으므로 생략한다고 언급합니다. * **03:55 - 04:30 Python API를 통한 Claude Code 사용 (Using Claude Code via Python API)** * 생성된 코드를 파이썬 API에서도 사용할 수 있는 방법을 시연합니다. * Anthropic 호환 파이썬 코드에서 `base_url`을 `http://localhost:11434`로, `api_key`는 임의의 값으로 설정하고 QN3 Code 모델을 사용합니다. * 소수(prime number)를 확인하는 함수 작성을 요청하며, `pip install anthropic`을 통해 Anthropic SDK (Software Development Kit)를 설치해야 함을 강조합니다. * 코드를 실행하면 QN3 Code를 통해 함수가 성공적으로 생성되고 작동하는 것을 보여줍니다. * **04:30 - 05:40 툴 콜(Tool Call) 예제 시연 (Demonstrating Tool Call Example)** * 툴 콜(Tool Call) 기능의 중요성과 작동 원리를 설명합니다: 자연어 프롬프트를 통해 외부 기능(함수)에 접근하고 실행하는 기능입니다. * 사용자가 날씨에 대해 물어보면, QN3 Code 모델이 자연어 프롬프트를 함수 호출로 변환하고 실행하는 방식을 예시로 듭니다. * Claude Code에는 '스킬스(Skills)' 같은 기능도 있지만, 이는 다른 영상에서 다룰 것이라고 언급하며, 이 영상에서는 간단한 툴 콜 예제를 보여줍니다. * Anthropic SDK의 `messages.create` 기능을 사용하여 툴 콜 예제 코드를 실행합니다. 이 코드는 Ollama를 통해 호출됩니다. * 코드를 실행하면 도구(tool)와 입력값(input)이 전달되고 결과(result)가 반환되는 것을 보여주며, 이 기능이 간단하고 깔끔하게 작동함을 강조합니다. * **05:40 - 06:20 Ollama의 Anthropic 호환성 확장 기능 (Extended Features of Ollama's Anthropic Compatibility)** * Ollama의 Anthropic 호환성 덕분에 메시지 기능, 멀티턴 대화(Multi-turn conversation), 스트리밍(Streaming), 시스템 프롬프트(System Prompts), 확장된 사고(Expanded thoughts, GPT-4o 등에서 본 것과 유사), 비전 이미지 입력(Vision image input) 등 다양한 기능이 가능해졌다고 설명합니다. * 특히 비전 이미지 입력은 Anthropic 모델에서 성능이 매우 뛰어나다고 언급합니다. * **06:20 - 07:15 추가 정보 및 주의사항 (Additional Information and Caveats)** * Ollama의 Anthropic 호환성 문서(`docs.ollama.com`)에서 지원되는 API 엔드포인트(Endpoint)와 기능을 확인할 수 있음을 안내하며, 영상 설명란에 링크를 남기겠다고 합니다. * 앞서 언급한 Ollama 업그레이드 영상 링크도 제공합니다. * 개발자라면 반드시 확인해야 할 유용한 기능이 많다고 강력히 추천합니다. * **주의사항:** 상황이 매우 빠르게 변하고 있으므로 Anthropic이 이 기능을 언제까지 허용할지, 얼마나 오랫동안 지원할지는 불확실하다고 경고합니다. 이전에 Anthropic이 오픈 코드(Open Code)와 같은 오픈 리소스 도구들이 기반 모델을 사용할 수 없게 차단했던 전례를 언급하며 영상을 마무리합니다. 💡 추천 8/10 | Anthropic Claude Code를 비용 부담 없이 로컬에서 사용하고자 하는 개발자, Ollama를 활용하여 다양한 LLM을 로컬 환경에서 구축하고 실험하는 AI/ML 엔지니어 및 연구자, API 종속성에서 벗어나 로컬 LLM 환경을 구축하려는 프리랜서 개발자 또는 스타트업, 로컬 LLM의 기능 확장 및 새로운 활용 가능성에 관심 있는 모든 기술 애호가 Ollama를 활용하여 Anthropic API 키 없이 Claude Code를 로컬에서 사용할 수 있는 혁신적인 방법을 제시하며, 개발자와 AI/ML 커뮤니티에 비용 절감 및 로컬 LLM 활용의 중요한 대안을 제공합니다. 최신 Ollama의 Anthropic Message API 호환성이라는 중요한 업데이트를 상세히 다루며 실용적인 활용법을 보여줍니다.

9176시간 전

프

프리랜서 개발자

구글이 몰래 공개한 역대급 AI 웹사이트 빌더 (Whisk & Antigravity 활용법)

구글의 AI 실험 도구인 Whisk와 Antigravity를 활용하여 어떻게 빠르고 효과적으로 고품질의 AI 생성 웹사이트를 구축할 수 있는가? Whisk로 일관되고 애니메이션화된 시각적 자산을 생성하고, Antigravity AI 에이전트 편집기로 이를 활용하여 프롬프트 기반으로 완벽하게 코딩된 웹사이트를 단 몇 분만에 무료로 만들 수 있습니다. Whisk와 Antigravity는 각각 어떤 원리로 작동하며, 어떻게 상호 보완적으로 웹사이트를 구축하는가? • **Whisk (프론트엔드 시각 자산 생성):** - 'Creative AI' 기능을 통해 프론트엔드에 필요한 구성 요소를 아이디어화하고 시각적 자산 라이브러리를 구축합니다. - Nano Banana AI 모델을 기반으로 이미지를 생성, 수정, 애니메이션화하며, 이를 통해 랜딩 페이지에 사용할 시네마틱 루프(cinematic loop)를 만듭니다. - '주제(Topic)', '장면(Scene)', '스타일(Style)', '프레임워크(Framework)'를 사용하여 자산 전반에 걸쳐 일관성을 유지하고, 각 요소가 조화롭게 어우러지도록 가이드된 이미지 생성을 가능하게 합니다. - 생성된 자산은 앱에서 재사용 가능하도록 저장 및 정리되어, 일관된 디스플레이 디자인과 레이아웃 및 시각적 요소의 빠른 반복 작업을 지원합니다. • **Antigravity (AI 에이전트 기반 웹사이트 코딩):** - Labs Google에서 제공하는 완전 무료 AI 에이전트 편집기로, 모든 운영 체제에 설치 가능합니다. - 사용자가 Whisk에서 생성한 시각적 자산을 입력하고, 구체적인 자연어 프롬프트(prompt)를 통해 원하는 웹사이트(예: '헤드셋 자산을 위한 전자상거래 스토어')를 지시합니다. - Gemini Pro AI 모델을 활용하여 사용자의 지시를 기반으로 웹사이트 구축 계획을 수립하고, HTML, CSS, JavaScript 등 필요한 모든 구성 요소를 자동으로 코딩하여 완전히 기능하는 웹페이지를 생성합니다. • **상호 보완적 워크플로우:** - Whisk는 웹사이트의 시각적 매력을 담당하는 고품질의 애니메이션화된 이미지 및 자산을 제공하여, 개발자가 디자인에 들이는 시간을 획기적으로 줄여줍니다. - Antigravity는 Whisk에서 생성된 시각 자산을 바탕으로 복잡한 코딩 작업 없이 프롬프트만으로 실제 동작하는 웹사이트를 구현하여, 개발 지식이 없는 사용자도 쉽게 웹사이트를 만들 수 있도록 돕습니다. 이 영상은 구글이 비밀리에 공개한 두 가지 AI 도구, Whisk와 Antigravity를 활용하여 누구나 쉽고 빠르게 고품질의 웹사이트를 구축할 수 있는 방법을 소개합니다. 과거 Gemini 출시 당시 보여진 'AI 생성 웹사이트' 데모들이 실제로는 상당수 가짜였고, 현재 AI 모델의 한계로 인해 모델 스스로 높은 수준의 프론트엔드를 생성하기 어렵다는 문제점을 지적하며 영상을 시작합니다. 그러나 Whisk와 Antigravity는 이러한 한계를 극복하고, 개발자가 몇 주 걸릴 작업을 AI가 단 몇 분 만에 무료로 해낼 수 있음을 시연합니다. 영상은 Whisk를 사용하여 웹사이트에 필요한 아름다운 시각적 자산을 생성하고 애니메이션화하는 과정부터, Antigravity를 통해 이 자산들을 기반으로 완벽하게 코딩된 웹사이트를 만드는 전 과정을 상세히 보여줍니다. 이 두 도구는 Labs Google에서 무료로 제공되며, 사용자가 코딩 지식 없이도 창의적인 아이디어를 실제 웹사이트로 구현할 수 있도록 돕는 혁신적인 워크플로우를 제시하는 것이 영상의 주요 목표입니다. 00:00 - 00:23 영상 도입부: AI가 완전히 생성한 웹사이트를 보여주며, 개발자가 몇 주 걸릴 작업을 AI가 해냈다고 강조합니다. 이 모든 것이 무료이며, 구글의 새로운 실험 기능인 Whisk와 Antigravity를 사용했다고 소개합니다. 00:23 - 00:54 과거 AI 웹사이트 데모의 한계 지적: Gemini 출시 시 보았던 멋진 랜딩 페이지 데모들이 대부분 '가짜'였음을 언급합니다. 현재 모델은 올바른 리소스에 접근할 수 없거나 긴 문맥을 처리하지 못하는 등 근본적인 한계 때문에 고품질 프론트엔드를 스스로 만드는 것이 불가능했음을 설명합니다. 00:54 - 01:28 Whisk의 기능 소개 (자산 라이브러리 구축): Whisk는 단순히 시각적 요소를 생성하는 것을 넘어, 워크플로우의 일부로서 앱을 위한 자산 라이브러리(asset library)를 구축해준다고 설명합니다. 모든 이미지는 애니메이션화될 수 있으며, 앱에서 사용할 수 있도록 저장 및 정리되는 구성 요소와 스타일 변형을 생성합니다. 이는 모델이 다음 단계에서 참조할 수 있는 재사용 가능한 자산 컬렉션을 만드는 것입니다. Labs Google 계정만 있으면 무료로 사용할 수 있습니다. 01:28 - 01:45 Whisk의 Nano Banana 엔진 활용: 카메라 사진을 Creative AI화하여 애니메이션 랜딩 페이지를 위한 시네마틱 루프(cinematic loop)를 만들 수 있다고 설명합니다. 이는 Nano Banana AI 모델에 의해 구동되는 기능으로, 자신의 이미지를 업로드하거나 모델로 수정하거나 텍스트 프롬프트를 입력해 이미지를 생성할 수 있습니다. 01:45 - 02:22 Whisk의 핵심 가치: 웹사이트를 위한 아름다운 자산 생성물을 얻어 이상적인 랜딩 페이지 디자인에 도움을 줍니다. 시각적 요소를 생성하는 자산 도구로 활용하여 히어로 섹션(hero section)이나 기능 섹션 등 랜딩 페이지의 주요 섹션을 채울 수 있습니다. 단순히 이미지를 생성하는 것이 아니라 재사용 가능한 자산 라이브러리를 구축하여 일관된 디스플레이 디자인과 레이아웃 및 시각적 요소의 빠른 반복(iteration)을 가능하게 합니다. 02:22 - 02:49 Whisk의 '주제-장면-스타일' 프레임워크: 이 도구는 '주제(Topic)', '장면(Scene)', '스타일(Style)', '프레임워크(Framework)'를 사용하여 이미지 생성을 가이드함으로써 자산 전반에 걸쳐 일관성을 제공하고 각 요소가 매끄럽게 어우러지도록 보장합니다. 이는 조화롭고 아름다운 웹사이트를 만드는 데 기여하며, 무작위로 생성된 정적인 이미지에 의존하는 것보다 훨씬 낫다고 강조합니다. 02:49 - 03:09 Whisk 활용 시나리오: 랜딩 페이지를 위해 가이드된 이미지 생성과 애니메이션이 있는 여러 장면을 원한다면 Whisk를 사용할 수 있다고 설명합니다. 03:09 - 03:49 Whisk 사용법: '주제(Topic)' 생성: 메인 제품 샷(main product shot)으로 무엇을 보여줄지 결정합니다 (예: 메인 객체, 사람, 이미지의 초점). 텍스트 프롬프트로 Nano Banana를 통해 생성하거나 직접 이미지를 업로드하여 다듬을 수 있습니다. 03:49 - 04:15 Whisk 사용법: '장면(Scene)' 및 '스타일(Style)' 업로드: 주제가 속할 환경이나 맥락인 '장면'을 업로드하거나 프롬프트로 생성합니다. 미적인 루프나 예술적인 처리, 시각적 분위기를 의미하는 '스타일'을 업로드합니다. 이 모든 것을 선택한 후 전체 장면을 프롬프트할 수 있습니다. 04:15 - 04:54 Whisk 사용법: 사진 시퀀스 생성 및 애니메이션화: 주제, 장면, 스타일을 선택한 후 사진 시퀀스(photo sequence)를 생성할 수 있습니다. 랜딩 페이지에서 강조하고 싶은 내용을 구체적으로 묘사합니다. 생성된 헤드셋의 사실적인 제품 샷을 예시로 보여주며, 특정 요소를 편집할 수 있는 기능도 있다고 언급합니다. 이 시퀀스를 정적인 상태로 다운로드하거나, 애니메이션화하여 랜딩 페이지 배경으로 사용할 수 있습니다. 04:54 - 05:40 Whisk 사용법: 애니메이션 적용 예시: 애니메이션 버튼을 클릭하고 '부드러운 360도 회전 애니메이션을 Creative AI 해줘'와 같은 설명적인 프롬프트를 제공하여 쉽게 애니메이션을 생성합니다. 생성된 헤드폰의 360도 회전 애니메이션을 시연하며, 이를 다운로드하여 랜딩 페이지 구축을 위해 Antigravity로 가져갈 수 있음을 설명합니다. 05:40 - 06:17 Antigravity 소개 및 설치: 다음 단계로 `labs.gravity.labs.google`을 소개합니다. 이는 Labs Google의 완전 무료 AI 에이전트 편집기(AI agent editor)이며, 어떤 운영 체제에도 설치할 수 있습니다. 설치 후 만들고 있는 랜딩 페이지나 웹사이트를 위한 폴더를 생성하고, Whisk에서 생성한 자산을 추가합니다. 06:17 - 06:47 Antigravity로 웹사이트 생성 프롬프트: 에이전트에게 작업을 지시하는 프롬프트 단계입니다. Whisk에서 생성한 자산을 활용해 완전히 기능하는 랜딩 페이지나 웹을 생성하도록 가능한 한 구체적으로 지시합니다. 예시로 '이 헤드셋 자산을 위한 전자상거래 스토어를 만들고 있어. 이것을 배경으로 사용할 거야'와 같은 설명을 합니다. 그리고 '나를 위해 아름다운 랜딩 페이지를 Creative AI 해달라'고 요청합니다. 06:47 - 07:18 Antigravity의 실행 및 결과물: Antigravity는 Gemini Pro AI 모델을 사용하여 먼저 계획을 수립하고, 지시한 작업을 실행하여 모든 구성 요소를 Creative AI합니다. 결과물의 품질을 보여주며, Whisk AI 자산을 참조하고 Antigravity에 프롬프트를 보냈을 뿐인데 이렇게 아름다운 랜딩 페이지를 생성할 수 있었다고 강조합니다. 07:18 - 07:44 시간 절약 효과 및 결론: 일반 개발자가 몇 주는 걸렸을 작업을 AI 워크플로우로는 단 10분 만에 완료했음을 강조합니다. Whisk와 Antigravity로 진정 기대할 수 있는 것이 이것이라고 요약하며, 웹페이지와 애플리케이션을 더 잘 디자인하는 아름다운 새로운 방법을 알아보았다고 마무리합니다. 두 도구 모두 Labs Google의 놀라운 완전 무료 도구임을 다시 한번 언급하며 영상을 마칩니다. 💡 추천 8/10 | 프리랜서 개발자, 웹 디자이너, 스타트업 창업가, 마케터, 랜딩 페이지나 웹사이트를 신속하게 프로토타이핑하거나 구축하고 싶은 개인, AI 기반 웹 개발 도구에 관심 있는 모든 사용자 이 영상은 구글의 최신 AI 기술을 활용하여 웹사이트를 빠르고 효율적으로 구축하는 혁신적인 방법을 제시하며, 코딩 지식이 없는 사람도 고품질의 랜딩 페이지를 만들 수 있게 돕는 유익하고 실용적인 정보를 제공합니다.

6037시간 전

프

프리랜서 개발자

DeepSeek이 해냈다? AI 추론 능력을 폭발시킨 '기억의 혁명'

DeepSeek의 Engram이 해결하고자 하는 핵심 문제는 무엇이며, 도입하는 핵심 개념은 무엇인가? 기존 AI 모델이 반복적인 패턴을 비효율적으로 재학습하는 문제를 해결하기 위해, DeepSeek의 Engram은 MoE(Mixture of Experts) 모델에 '기억 모듈(memory module)'을 통합하여 흔한 패턴 처리를 전담하게 함으로써 추론 능력과 장문 맥락 이해도를 획기적으로 향상시키고 시스템 효율성을 극대화한다. Engram은 어떤 원리와 메커니즘으로 AI의 추론 능력을 향상시키고 효율성을 높이는가? • **비효율적인 반복 학습 문제 해결:** 기존 AI는 'Alexander the Great'와 같은 흔한 개념이나 문구를 볼 때마다 내부적으로 끊임없이 재구성하며 연산 자원을 낭비함. Engram은 이러한 반복적인 '상식'을 학습이 아닌 기억으로 처리해야 한다는 통찰에서 출발. • **지름길 기억 테이블 (Shortcut Memory Table) 및 해시 시스템:** 복잡한 수학적 연산을 통해 패턴을 계산하는 대신, 자주 등장하는 짧은 단어 패턴(n-gram)을 위한 '지름길 기억 테이블'을 구축. 해시 시스템(hash system)을 사용하여 수십억 개의 패턴을 거대하고 정돈된 '창고'에 저장하고, 각 패턴에 고유한 '선반 번호'를 부여하여 즉시 접근 가능하게 함. • **상수 시간 조회 (Constant Time Lookup) 및 기억 게이트 (Memory Gate):** 기억 모듈의 크기와 관계없이 패턴 조회 속도가 일정한 '상수 시간 조회'를 가능하게 함. 또한, 오해나 노이즈를 방지하기 위해 MoE 내부에 '기억 게이트'를 두어 기억된 정보가 현재 맥락과 일치하는지 확인하고, 일치하지 않으면 무시하여 신뢰도를 높임. • **MoE와의 최적 통합 및 역할 분담:** DeepSeek은 MoE의 전체 용량 중 전문가(experts)와 기억(memory)에 할당할 최적의 비율을 수학적으로 탐색. 실험 결과, 전체 신경망 용량의 약 20-25%를 기억 모듈에 할당할 때 가장 효율적이라는 것을 발견. 이는 모든 부분이 전문가일 필요 없이, 일부는 기억이 되어야 한다는 새로운 아키텍처 결론을 제시. • **추론 능력 향상의 메커니즘:** Engram이 반복적인 패턴 재구성이라는 '지루한 단순 작업(grunt work)'을 전담함으로써, MoE의 초기 트랜스포머(Transformer) 계층들이 더 일찍 고수준의 유용한 표현에 도달하고 '깊은 사고'에 집중할 수 있게 함. 이는 MoE 계층을 추가하지 않고도 '뇌에 추가적인 깊이'를 부여하는 것과 같으며, CKA 층 유사도 분석(layer similarity analysis)을 통해 얕은 Engram 층이 깊은 기본 층과 유사하게 작동함을 입증. • **긴 문맥 (Long Context) 처리 능력 강화 및 시스템 효율성:** Engram이 국소적인 패턴 기억을 처리하여 어텐션(attention) 메커니즘이 반복적인 세부사항에 낭비되지 않고 전체적인 문맥에 집중할 수 있게 함으로써 긴 문맥 처리 능력을 크게 향상시킴. 또한, 기억 조회가 결정론적(deterministic)이므로 MoE가 해당 층에 도달하기 전에 필요한 기억을 미리 가져올 수 있어, 방대한 양의 기억을 추가하더라도 추론 속도 저하가 거의 없는 높은 시스템 효율성(throughput)을 달성. 기존 AI 개발의 주요 전략은 모델 크기를 키우는 것이었으나, 이는 막대한 운영 비용이라는 한계에 부딪혔습니다. 이를 극복하기 위해 등장한 MoE(Mixture of Experts) 방식은 AI가 특정 순간에 뇌의 일부만 활성화하여 효율적인 확장을 가능하게 했습니다. 하지만 DeepSeek은 MoE 모델조차도 인간이 자연스럽게 가지는 '진정한 기억(true memory)'이 부족하다고 지적합니다. 현재 AI는 '알렉산더 대왕'과 같은 흔한 이름이나 문구를 접할 때마다 매번 내부적으로 재구성하며 비효율적인 연산을 반복합니다. 인터넷이 반복적인 패턴으로 가득 차 있다는 점을 고려할 때, 이는 거대한 낭비입니다. DeepSeek은 이러한 비효율성을 해결하기 위해 'Engram'이라는 혁신적인 기억 모듈을 선보였습니다. Engram은 MoE 모델에 빠른 기억 기능을 추가하여, 흔한 패턴과 상식을 미리 학습하고 즉시 인출할 수 있도록 함으로써, 메인 AI 뇌가 단순한 작업에 시간을 낭비하지 않고 고차원적인 추론과 복잡한 문제 해결에 집중할 수 있도록 하는 것을 목표로 합니다. **AI 발전의 한계와 MoE의 등장** - **기존 AI 스케일링 전략:** '더 크면 더 똑똑하다'는 철학 아래 파라미터(parameters), 훈련 데이터, 연산 능력 증대에 집중. - **문제점:** 모델이 너무 거대해져 실행 비용이 천문학적으로 증가 (질문 하나에 도시 전체 전력 소모 비유). AI 발전이 한계에 봉착. - **MoE(Mixture of Experts)의 도입:** 확장성 해결을 위한 핵심 전략으로 부상. - **원리:** 모든 문장에 대해 뇌 전체를 사용하는 대신, AI가 한 번에 뇌의 일부 전문가(expert)만 활성화. - **효과:** 매초 엄청난 연산 없이도 모델 크기를 크게 확장 가능하게 하여, 대부분의 업계 전문가들이 '미래'라고 생각. **DeepSeek의 통찰: '진정한 기억'의 부재** - **MoE의 한계 지적:** DeepSeek은 MoE가 확장은 하고 있지만, 여전히 '진정한 기억(true memory)'이라는 중요한 요소를 놓치고 있다고 주장. - **인간과 AI의 기억 방식 차이:** - **인간:** '알렉산더 대왕'과 같은 익숙한 개념을 보면 처음부터 다시 생각하지 않고 즉시 인식. 저장되어 있고 빠르고 자동적. - **현재 AI:** 훈련 중에 수백만 번 접했더라도, 문장 내에서 볼 때마다 놀라울 정도로 많은 노력을 들여 내부적으로 재구성. 이는 비효율적이며, 인터넷이 반복되는 이름, 문구, 장소, 표현 등으로 가득하다는 점을 고려할 때 거대한 문제. - **핵심 문제 인식:** 무거운 연산이 아니라 '기억'으로 처리해야 할 부분들을 AI가 비효율적으로 계산하고 있음. **DeepSeek Engram의 등장 및 작동 방식** - **Engram의 아이디어:** AI MoE가 흔한 패턴을 위한 '빠른 기억 모듈(fast memory module)'을 가지면, 메인 뇌가 단순한 것에 시간을 낭비하지 않고 '생각'하는 데 집중할 수 있을 것이라는 철학. - **기원:** 현대 AI 이전 언어 예측의 초기 개념(n-gram, 즉 단어 패턴)에서 착안. - **'지름길 기억 테이블(shortcut memory table)' 구축:** - 'princess of Wales', 'United States', 'New York City'와 같이 끝없이 반복되는 단어 패턴들을 AI가 층(layer)을 거쳐 깊은 수학 연산을 통해 계산하도록 강요하는 대신, 기억 테이블 생성. - **작동 원리:** MoE가 특정 패턴을 보면 즉시 해당 패턴에 대한 '기억 임베딩(memory embedding)'을 꺼낼 수 있도록 함. - **해시 시스템(hash system) 활용:** 모든 가능한 문구를 직접 저장할 수 없으므로, 해시 시스템을 사용하여 수십억 개의 기억 슬롯을 가진 거대하고 정돈된 '창고'에 패턴을 저장. 각 문구 패턴에 선반 번호를 부여하여 AI가 즉시 해당 선반으로 점프하여 필요한 것을 꺼낼 수 있도록 함. - **상수 시간 조회(Constant Time Lookup):** 기억 모듈의 크기와 관계없이 조회 속도가 빠름을 의미. - **'기억 게이트(Memory Gate)'를 통한 확인:** - **필요성:** 기억 시스템이 때때로 엉뚱한 것을 꺼낼 수 있고, 비슷한 패턴들이 가깝게 저장되어 노이즈가 발생할 수 있기 때문. - **원리:** AI는 기억을 맹목적으로 신뢰하지 않고, MoE 내부에 작은 '진실 탐지기'와 같은 검증 절차를 거침. - **기능:** 기억이 정보를 가져오면 메인 AI 뇌가 '이것이 지금 이야기하고 있는 것과 일치해, 아니면 충돌해?'라고 물음. 일치하면 받아들이고, 일치하지 않으면 억제. 논문에서는 0과 1 사이의 값을 출력하는 게이트로 설명. - **역할:** Engram 기억은 MoE를 장악하는 것이 아니라, 뇌 속의 '조수'처럼 지원하는 역할. **Engram의 스케일링 및 최적화** - **대규모 확장:** DeepSeek은 Engram을 장난감처럼 단순히 붙인 것이 아니라, 심각한 수준으로 확장. - **훈련 환경:** 딥시크 V3와 동일한 토큰아이저(tokenizer) 시스템, 128,000 토큰의 거대한 어휘 크기, 2,620억 토큰으로 훈련. - **핵심 아키텍처:** 30계층의 트랜스포머(Transformer), 히든 사이즈 2560, 32개 어텐션 헤드(attention head). - **MoE와의 결합:** 이미 딥시크 시스템의 일부인 MoE와 Engram을 결합. MoE가 활성화할 수 있는 '전문가(expert)'들과 '기억(Engram)'을 동시에 가짐. - **최적의 비율 탐색:** 'MoE에서 전문가와 기억 중 얼마나 많은 부분이 되어야 할까?'라는 핵심 질문을 수학적 문제로 공식화. - **발견:** 최적의 지점이 존재. 기억 없이 전문가만 너무 많으면 단순 패턴 재구성에 시간 낭비, 기억만 너무 많고 전문가가 적으면 깊은 사고 능력 상실. - **결론:** 실험 결과, 전체 신경망 용량의 약 20-25%가 기억으로 가야 하는 '최적의 균형'을 발견. 모든 것이 전문가일 필요는 없으며, 일부는 기억이어야 한다는 중요한 아키텍처 결론. **실험 결과 및 성능 향상** - **비교 모델:** - 순수 MoE: 총 270억 파라미터. - Engram 27B: 총 267억 파라미터 (동일 연산 예산, 아키텍처 골격). 전문가 수를 72개에서 55개로 줄이고, 남은 파라미터를 기억(57억 파라미터)으로 전환. - Engram 40B: 더 강력하게 확장. 토큰당 연산량은 같지만, 기억 파라미터를 185억으로 늘려 총 395억 파라미터. (뇌가 더 어렵게 생각하게 만드는 것이 아니라, 훨씬 더 큰 기억 도서관을 주는 것). - **전반적인 승리:** Engram이 전반적으로 순수 MoE를 압도. - **손실 점수(Loss Score) 감소 (Pile 벤치마크):** 일반 MoE: 2.091 → Engram 27B: 1.960 → Engram 40B: 1.94 (내부 검증실 손실도 1.768에서 1.60으로 대폭 감소). - **벤치마크 점수 대폭 향상 (예상치 못한 결과):** - **지식 기반 작업 (예상된 향상):** MMLU: 57.4 → 60.4, 중국어 MMLU: 57.9 → 61.9, C-Eval: 58.0 → 62.7. - **'순수 사고' / 추론 작업 (놀라운 향상):** ARC Challenge: 70.1 → 73.8, BBH: 50.9 → 55.9, DROP F1: 55.7 → 59.0, 코딩 (HumanEval): 37.8 → 40.8, 수학 (GSM8K): 58.4 → 60.6. - **결론:** DeepSeek의 기억 모듈은 지식 작업뿐만 아니라 추론, 코딩, 수학 능력까지 향상. **추론 능력 향상에 대한 DeepSeek의 설명** - **원리:** 일반 트랜스포머의 초기 계층(layer)들이 반복적인 개체와 패턴을 재구성하느라 막대한 노력을 낭비. Engram이 이 '지루한 단순 작업(grunt work)'을 처리. - **효과:** MoE가 유용한 표현에 더 일찍 도달하며, '추가적인 깊이'를 얻는 것과 같음. - **메커니즘 분석 (CKA 층 유사도 분석):** 얕은 Engram 층들이 훨씬 더 깊은 층처럼 행동함을 입증 (예: Engram 5번째 층이 베이스라인 12번째 층과 일치). MoE가 더 빨리 '깊어짐'. - **결과:** 초기 계층들이 반복적인 개체 재구성에 에너지를 소모하지 않으므로 추론 능력이 크게 향상. **긴 문맥(Long Context) 처리 능력 향상** - **훈련:** 사전 훈련 후, YaRN 방법을 사용하여 문맥 창(context window)을 32,768 토큰으로 확장. 300억 개의 긴 문맥 토큰에 대해 5,000 스텝 동안 훈련. - **성능:** 긴 문맥 벤치마크에서 Engram이 특히 '건초더미 속 바늘 찾기(haystack-in-a-needle)' 작업에서 뛰어난 성능. - Multi-Coloured Needles / Haystack: 84.2 → 97.0 - Variable Tracking: 77.0 → 89.0 - **원리:** Engram이 국소적인 패턴 기억을 처리하면, 어텐션(attention) 메커니즘이 작고 반복적인 것에 낭비되지 않고 전체적인 문맥에 집중할 수 있게 되어 긴 문맥 작업에 더 유리. **시스템 효율성 (Inference Efficiency)** - **설계 목표:** 실제 세상에서 작동 가능하도록 인퍼런스(inference) 방식에 최적화. - **결정론적 기억 조회:** 기억 조회가 결정론적(deterministic)이므로, 시스템은 MoE가 해당 기억 층에 도달하기 전에 어떤 기억이 필요할지 미리 예측하고 가져올 수 있음 (pre-fetching). - **처리량(throughput) 테스트:** 거대한 1억 파라미터 Engram 층을 삽입하고, CPU 메모리로 완전히 오프로드(offload)한 상태에서 테스트. - **결과:** 처리량 타격이 아주 작음. 80억 댄스 MoE의 경우 초당 6,315.52 토큰에서 6,142 토큰으로 감소, 약 2.8%의 페널티. - **결론:** 말도 안 되는 양의 기억을 붙여도 시스템이 적절하게 설계되기만 하면 추론 속도가 거의 느려지지 않는다는 것을 증명. **기억 게이트(Memory Gate) 시각화:** - **활성화 지점:** 개체 완성이나 흔한 문구(예: 'Alexander the Great', 'princess of')에서 정확히 예상한 대로 활성화. - **중국어 유명 역사 표현에서도 활성화:** MoE가 기억을 '실제 패턴 인식 시스템'처럼 사용하고 있음을 의미. 💡 추천 9/10 | 대규모 언어 모델(LLM) 개발자 및 연구자, AI 아키텍처 및 효율성에 관심 있는 기술 전문가, 최신 AI 기술 트렌드를 이해하고 싶은 일반 기술 애호가 AI 모델의 비효율적인 반복 학습 문제를 해결하고 '기억'이라는 새로운 차원을 도입하여 추론, 코딩, 수학 및 장문 맥락 이해 능력을 획기적으로 향상시킨 혁신적인 연구입니다. 최소한의 시스템 효율성 저하로 실질적인 성능 향상을 달성하여 AI 아키텍처의 새로운 방향을 제시합니다.

13077시간 전

빌

빌더 조쉬 Builder Josh

"배민은 이제 노가다 안 합니다" 1시간 업무를 1분만에 끝내는 AI 자산화의 비밀(우아한형제들 임동준님)

[영상의 핵심 질문]은 무엇이며, [핵심 개념]은 무엇인가? 조직이 AI를 활용하여 수동적이고 시간이 많이 소요되는 작업을 표준화된 재사용 가능한 자산으로 전환하고, 이를 통해 생산성과 일관성을 극대화하는 방법을 다룹니다. 핵심 개념은 'AI 자산화(AI Assetization)'이며, 특히 작업이나 디자인 원리의 '에센스(Essence)'를 추출하여 이를 실현하는 것입니다. AI 자산화를 통해 생산성과 일관성을 극대화하는 핵심 메커니즘과 원리는 무엇인가? • **에센스(Essence) 추출 및 추상화(Abstraction)**: 특정 작업, 디자인 스타일, 또는 문제 해결 방식의 핵심적인 본질과 최소한의 특징을 식별하고 추출하는 과정입니다. 이는 군더더기를 제거하고, 본질적인 구성 요소(예: 배민 디자인의 '깎은 듯한' 질감과 명도 대비, 디버깅의 핵심 5단계)를 정의하여 AI가 이를 기반으로 일관된 결과물을 생성할 수 있도록 가이드하는 역할을 합니다. 에센스는 AI에 대한 '스타일 참조' 또는 '명확한 의도'로 작용합니다. • **표준화된 프롬프트 및 시스템을 통한 자산 자동화(Automated Asset Creation via Standardized Prompts and Systems)**: 추출된 에센스를 AI 도구(예: Adobe Firefly, Claude Skills)의 입력(Input)으로 활용하여, 짧고 명확한 프롬프트만으로도 대량의 고품질 자산(예: 다양한 배민 스타일 오브젝트, 12지신 캐릭터)을 일관된 형태로 신속하게 생성합니다. 이는 기존의 수작업 공수를 획기적으로 줄이고, 비전문가도 전문적인 수준의 결과물을 만들 수 있도록 지원하는 핵심 원리입니다. • **명확한 성공 기준 정의 및 불변 테스트(Define Clear Success Criteria & Immutable Tests)**: AI 활용의 성공 여부를 명확히 판단하기 위해, 특정 작업이 '올바르게 동작한다면 어떠해야 하는가'에 대한 구체적인 성공 기준을 사전에 정의합니다. 개발 영역에서는 켄트 백(Kent Beck)의 철학처럼 AI가 코드를 생성해도 테스트 코드 자체(의도와 명세)는 변경할 수 없도록 '불변 테스트(Immutable Tests)'를 작성하여 AI의 예측 불가능성을 통제하고 신뢰성을 확보하는 것이 중요합니다. • **인간 지식 및 경험의 자산화(Assetization of Human Knowledge and Experience)**: 특정 분야의 전문가들이 가진 암묵지(Tacit Knowledge)와 성공적인 경험(Best Practices)을 명시적인 자산(Explicit Assets)으로 전환하는 과정입니다. 이는 '의도가 드러나는 네이밍(Intention Revealing Naming)'과 같은 개발 원칙이나 '디버깅 5단계 이정표'와 같은 구체적인 문제 해결 프로세스를 체계적으로 문서화하고 공유 가능한 형태로 만들어, 팀원 전체의 역량을 상향 평준화하고 효율적인 협업을 가능하게 합니다. • **중앙 집중식 자산 관리 및 지속적인 개선(Centralized Asset Management & Continuous Improvement)**: 개인 또는 팀 단위로 파편화된 AI 활용 경험과 생성된 에센스 기반 자산들을 전사적인 플랫폼(예: 사내 AI 플랫폼, 공유 프롬프트 저장소, 지식 허브)을 통해 중앙에서 관리합니다. 이는 중복을 줄이고, 자산 간의 연계를 강화하며, 시대 변화에 따라 에센스와 자산 자체를 지속적으로 업데이트하고 개선할 수 있는 선순환 구조를 구축하여 조직의 AI 활용 능력을 장기적으로 발전시킵니다. 이 영상은 우아한형제들(배달의민족 운영사)의 프론트엔드 개발자 임동준 님을 모시고, AI를 활용하여 업무 생산성을 혁신하는 'AI 자산화(AI Assetization)'의 비결을 파헤칩니다. AI 기술의 장점은 모두가 알지만, 실제 현업에서 어떻게 효과적으로 적용하고 조직 전체의 역량으로 만들어나갈 것인가에 대한 고민에 집중합니다. 개인의 AI 활용 경험을 넘어, 이를 공유하고 확장 가능한 형태로 전환하는 것이 핵심 목표입니다. 영상은 특히 배달의민족 디자인 팀의 사례를 통해 AI 자산화의 실질적인 가치를 생생하게 보여줍니다. 과거 수작업으로만 가능했던 복잡하고 일관된 디자인 자산(예: 스컬피 스타일의 3D 오브젝트) 제작 과정을, 핵심 '에센스(Essence)'를 추출하여 생성형 AI에 적용함으로써 혁신적으로 단축하고 표준화한 경험을 공유합니다. 이를 통해 디자이너들은 단순 반복 작업에서 벗어나 더 중요한 기획과 창의적인 업무에 집중할 수 있게 되었음을 강조합니다. 더 나아가 개발 영역에서의 AI 자산화, 특히 레거시 코드(Legacy Code) 마이그레이션(Migration)과 디버깅(Debugging) 과정에 AI를 어떻게 적용할지에 대한 심도 깊은 논의를 펼칩니다. 켄트 백(Kent Beck)과 같은 소프트웨어 대가의 AI 활용 철학을 인용하며, '의도 명확화'와 '프리프롬프트 엔지니어링(Pre-Prompt Engineering)'의 중요성을 강조합니다. 궁극적으로 이 영상은 AI 시대를 맞이하여 조직이 지식과 경험을 어떻게 자산화하고, 이를 통해 더 큰 비전을 실현하며 지속적으로 성장할 수 있을지에 대한 구체적이고 실용적인 가이드라인을 제시합니다. 00:00 - 01:20: 영상 소개 및 임동준 개발자 자기소개 - 빌더 조쉬의 영상 제목 언급: "배민은 이제 노가다 안 합니다" 1시간 업무를 1분만에 끝내는 AI 자산화의 비밀. - 임동준 개발자 (우아한형제들 프론트엔드 개발자) 소개: 우아한 테크코스(Woowa Techcourse) 운영, 개발자 및 비개발자 대상 AI 교육 활동 진행. - 현업 AI 적용 사례에 대한 대중의 높은 관심 및 AI 활용 노하우 공유의 중요성 강조. 01:20 - 02:25: '자산화(Assetization)' 키워드 및 디자인 사례 소개 - 임동준 개발자의 AI 활용 핵심 키워드: "자산화"(Assetization). - 개인의 경험에 머무르지 않고, 전문성과 활용 방법을 자산으로서 관리하고 공유하여 AI 역량을 함께 성장시키는 데 관심. - 특히, 배달의민족의 유명한 디자인 자산을 중심으로 자산화 사례 공유. 디자인 쪽에서 AI를 잘 쓰는 사례에 대한 높은 반응. 02:25 - 04:45: 배달의민족 디자인 자산 제작의 어려움 (AI 도입 이전) - 배달의민족의 독특한 '깎은 듯한' (Sculpey, 스컬피) 3D 모델링 디자인 아이덴티티 설명. - 과거에는 이 디자인 자산들을 '사람이 손으로 직접 깎아서' 만들었음 (스컬피 공예, Hand-sculpting). - 캐릭터의 다양한 동작 등 수많은 자산을 수작업으로 만들고, 사진 촬영, 누끼 따기, 포토샵(Photoshop) 작업 등 막대한 수작업 공수가 필요했음. - 높은 퀄리티에도 불구하고, 새로운 요청(기획/마케팅)에 대한 높은 제작 비용과 시간 소요로 인한 어려움 강조. - '생존을 위해' AI 도입의 필요성 절감. 04:45 - 06:15: AI를 통한 디자인 자산화의 핵심: '에센스 추출(Essence Extraction)' - AI로 디자인 자산을 만들 때 중요한 성공 기준: 100개든 1,000개든 '일관된 키 비주얼 언어(Consistent Key Visual Language)' 유지. - AI로 일관된 이미지/글/동영상을 만들기 어려운 점 지적. (LLM의 비일관성 문제) - 원래 예술가나 디자이너들이 잘하는 '본질(에센스) 뽑기'의 중요성 강조. 군더더기를 다 빼고 핵심적인 본질을 추출하여 그것을 가지고 실험하는 방식 설명. 06:15 - 08:35: 배달의민족 디자인 에센스 추출 및 AI 활용 사례 - 배달의민족 디자인 자산의 에센스 예시: 깎은 듯한 느낌, 명도 대비(Contrast)가 돋보이는 오브젝트 하나를 추출하여 스타일 레퍼런스로 사용. - 이 에센스를 AI(Adobe Firefly의 스타일 참조 기능)에 넣고 "딜리버리 스쿠터 프론트 뷰"와 같은 짧은 프롬프트(Prompt)로 일관된 스타일의 오토바이 자산 생성 시연. - 메인 오브젝트 생성 후 그림자, 컬러, 배경, 텍스트 추가 등은 디자이너에게 쉬운 작업이므로, 메인 오브젝트 제작 시간 단축이 핵심. - 에센스를 잘 뽑으니 나머지 작업이 쉬워지는 과정에 대한 충격 언급. - 에센스에 대한 추가 실험: 민티 컬러, 갈색, 다크 톤 스컬피 등 여러 요소를 쪼개어 에센스로 활용, 더욱 정교한 결과물(색상까지 입힌 오토바이) 생성. - 프롬프트는 여전히 짧지만, 에센스 조합을 통해 원하는 결과물을 한 번에 얻는 효율성 강조. 08:35 - 10:20: 디자인 자산화 시스템의 성과 및 시사점 - 에센스 기반 디자인 자산화 시스템 구축 후 퍼포먼스(Performance) 향상: 그래픽 자산 제작에 대한 두려움 감소. - 인턴이나 신입도 2~3년차 디자이너 수준의 결과물 제작 가능. - 디자이너들이 핵심 기획이나 다른 중요한 부분에 더 집중할 수 있게 됨. - 회사에서 AI를 잘 쓴다는 것의 의미: 에센스 등 핵심 포인트를 뽑아 자산화하여 '다른 사람들이 일관된 결과물을 만들 수 있게 하는 것'의 중요성 깨달음. 10:20 - 13:00: 개인 프로젝트에도 '에센스 추출' 적용 사례 - 임동준 개발자 개인 프로젝트(사주/타로 서비스용 12지신 캐릭터)에도 에센스 추출 적용. - 클레이(Clay) 느낌의 말 캐릭터에서 군더더기를 빼고, 따뜻한 그라데이션(Gradient), 그림자, 부드러운 파스텔톤(Pastel Tone) 등의 에센스를 추출. - 이 에센스로 "토끼 그려줘" 등 다른 12지신 캐릭터들을 일관된 느낌으로 생성. - AI를 잘 활용하기 위해 '에센스를 뽑고 일관된 결과물의 조건들을 갖추게 하는 것'의 중요성 재확인. 13:00 - 16:30: 에센스 추출 방법론: 워드 커닝(Ward Cunningham)의 '의도가 드러나는 네이밍(Intention Revealing Naming)' - 에센스를 잘 뽑는 방법에 대한 질문. LM이 인간 콘텐츠로 학습되었으므로, 인간의 지혜에서 답을 찾음. - '의도가 드러나는 네이밍'의 중요성 강조. - 워드 커닝(위키 창시자)의 '의도를 드러내는 네이밍' 3단계 에센스 소개: 1. 길어지더라도 의도를 드러낸다. 2. 구현 부분을 숨긴다. 3. 반환 타입(Return Type)에 대한 명확한 힌트를 제공한다. - 예시: '선형 검색을 통해 포함되어 있는지 안 됐는지 다 검색하는 전체 풀 네이밍' -> 'LinearSearch' -> 'Search' -> 'Includes'. 최종적으로 'Includes'는 의도(포함 여부)를 명확히 드러냄. - 과거 훌륭한 개발자들이 남긴 지혜에서 에센스를 얻고, 실무의 복잡한 맥락에서 팀원들의 에센스를 모으는 것이 중요하다고 강조. 16:30 - 19:10: 에센스 자산화의 실무 적용 및 관리 - 추출된 에센스(스킬)를 클로드 스킬스(Claude Skills)나 별도 마크다운(Markdown, .md) 파일에 담아 가이드라인으로 활용. - 프롬프트를 깃허브(GitHub) 프라이빗 저장소에 버전별로 관리하고, 개선 및 기여를 통해 자산화. - 대규모 조직에서는 팀별로 진행되는 자산화를 중앙 허브(Hub) 형태로 통합하려는 시도 진행 중 (예: SKT의 브랜드 가이드라인, 사내 AI 플랫폼 구축). - 중복을 줄이고 공유를 촉진하기 위한 사내 플랫폼의 필요성 강조. 19:10 - 22:45: 레거시 코드 마이그레이션(Legacy Code Migration)과 AI, 켄트 백(Kent Beck) 사례 - 개발자의 영원한 고민: 레거시 코드(Legacy Code)를 안전하게 마이그레이션(Migration)하는 방법. - Vue.js 기반 LMS를 React로 전환하는 마이그레이션 작업 중인 사례 언급. - 켄트 백(Kent Beck, TDD 창시자, 52년차 개발자)의 AI 활용 철학 소개. - 켄트 백의 발언: "원래 본인이 가진 스킬/기술의 90%는 0달러가 되었고, 나머지 10%는 1,000배의 가치를 얻게 됐다." -> 1,000배 가치를 얻은 10%가 무엇인가에 대한 질문으로 전환. 22:45 - 28:20: 켄트 백의 AI 활용 철학: '의도 명확화'와 '불변 테스트(Immutable Tests)' - AI(LLM)를 '예측 불가능한 지니(Unpredictable Genie)'에 비유. LLM이 원하는 바와 다르게 동작하거나, 테스트를 변경/삭제하는 등의 문제점 지적. - 감정 싸움으로 번질 수 있는 LLM과의 상호작용의 문제점. - 켄트 백의 해법: 진니를 완벽하게 통제하는 '램프(Lamp)'를 견고하게 만드는 것. - 개발에서 램프는 '테스트 코드 명세(Test Code Specification)'. - 핵심은 '의도를 명확하게 하는 것(Clarifying Intent)'과 '명세화(Specification)'. - AI에게 줄 수 있는 유일한 통제점은 '입력(Input)'. - 인풋-프로세스-아웃풋(Input-Process-Output, I-P-O) 모델에서 '인풋을 잘 다루는 것'의 중요성 강조. 28:20 - 32:45: 프리프롬프트 엔지니어링(Pre-Prompt Engineering) 디자인 패턴 - 임동준 개발자가 제안하는 '프리프롬프트 엔지니어링(Pre-Prompt Engineering)' 개념: 프롬프트 엔지니어링 이전에 해야 할 것들을 정의. - 좋은 프롬프트 작성을 위한 공부 자료: 엔트로픽(Anthropic) 공식 문서 추천 (가장 간결하고 에센스가 잘 담겨 있음). - 엔트로픽 공식 문서에서 강력히 권장하는 '프롬프트 엔지니어링 전 준비' 3가지 (프리프롬프팅 과정): 1. **사용 사례에 대한 명확한 성공 기준 정의(Define clear success criteria for the use case)**: LM이 잘 동작했는지 알 수 있는 명확한 기준 설정. 2. **경험적으로 테스트할 수 있는 환경 세팅 또는 반복 가능한 시스템 구축(Set up an environment for empirical testing or build a reproducible system)**: 프롬프트 버전 관리 등을 통한 테스트 환경 구축. 3. **개선하고 싶은 첫 번째 초안 프롬프트(First draft prompt to iterate on)**: 불필요한 핑퐁을 최소화할 수 있는 괜찮은 초안을 시작점으로 삼기. 32:45 - 34:10: TDD(테스트 주도 개발)와 LLM 활용의 연관성 - 켄트 백의 TDD(Test-Driven Development) 철학: 명확한 성공 기준 정의가 중요. - LLM을 활용한 개발에서 켄트 백은 '불변 테스트(Immutable Tests)' 작성을 강조. 테스트 자체(명세, 케이스)는 내 의도이므로 LLM이 수정해서는 안 되는 영역. - 우아한형제들 개발자들이 LLM을 가장 많이 쓰는 분야: 레거시 코드의 '테스트 케이스(Test Case) 작성'. - 리소스 부족으로 작성 못 했던 테스트 코드를 LLM으로 생성하여 코드 수정/개선 시 두려움 감소. 테스트 코드 자체도 중요한 자산임을 강조 (켄트 백의 '유용한 부산물' 개념). 34:10 - 36:50: 대기업의 AI 자산화 시도: 사내 플랫폼 구축 - 파편화된 AI 활용 경험을 중앙 집중적으로 자산화하지 않으면 어려움 가중. - GS, SK 등 대기업들이 사내 AI 플랫폼을 구축하는 사례 언급 (예: GS의 '미소' 서비스). - 전 구성원이 구독 없이 LLM을 활용하고, 만든 것들이 아카이빙(Archiving)되며, 반복 패턴 추출을 통해 자산화가 쉬워짐. - 우아한형제들도 '물어보세'와 같은 사내 전용 에이전트(Agent) 강화 계획 (기술 블로그 게시 예정). 파편화된 경험을 중앙 집중적으로 모으고 자산화하는 것의 중요성 강조. 36:50 - 41:50: 켄트 백의 '1,000배 가치를 만든 10% 에센스' 공개 및 임동준의 '디버깅 5단계 이정표' - 조쉬의 예측: 아키텍처 설계, 테스트 설계, 좋은 레퍼런스 문서화. - 켄트 백이 말하는 1,000배 가치를 만든 10% 에센스 3가지: 1. **야심 찬 비전 갖기(Having Ambitious Vision)**: LLM의 한계를 두지 않고, 어디까지 할 수 있을지 실험하며 좋은 문제 정의 및 설계. 2. **명확한 이정표 설정(Setting Clear Milestones)**: 추상적이고 복잡한 비전을 단계적으로 달성할 수 있는 중간 목표, 성공 기준, 테스트 코드 등 이정표 필요 (어려운 문제를 작게 쪼개는 것의 중요성). 3. **복잡성 통제(Controlling Complexity)**: 큰 그림을 보면서 설계 과정을 추적하고 복잡성을 관리하는 능력. - 임동준 개발자의 '이정표 문제 풀기' 자산화 예시: '디버깅(Debugging) 잘하기 5단계 이정표'. 1. **문제 한 문장으로 정의(Define the problem in one sentence)**: 정확한 문제 인지를 위한 구체적인 문제 정의 (예: "쿠폰 로직에 따른 금액 계산 결과가 정확하지 않다."). 2. **올바른 동작 정의(Define correct behavior)**: Given-When-Then(Given: 상황, When: 이벤트, Then: 결과) 구조로 명확한 성공 기준을 LLM과 함께 정의. 3. **최소 재현 환경 구축(Build a minimal reproducible environment)**: 문제의 스코프(Scope)를 줄여 함수 단위로 테스트 코드 작성 등 재현 가능한 환경 구축 (LLM에게 구축 방법 요청 가능). 4. **원인 옵션 나열(List potential causes/options)**: 에러 메시지, 스택 트레이스(Stack Trace) 등을 관찰하며 원인 후보 나열 (LLM 도움 및 동료 설명 통해 새로운 옵션 발굴). 5. **가설 검증(Verify hypotheses)**: 하나씩 동작시켜보며 진짜 원인 파악. - 이 디버깅 이정표를 Claude Skills 등에 넣어 관리하면 팀의 코딩/에이전트 활용 능력 향상 기대. 리팩토링, 테스트 작성, 네이밍, 코드 리뷰 등 다양한 전문 에센스를 자산화하려는 노력 지속. 41:50 - 45:10: 레거시(Legacy) 자산화의 지속 가능성 및 실시간 데이터 저장 - 레거시(암묵지 포함)가 시대 변화에 따라 계속 자산으로 관리될 수 있는가에 대한 질문. - 임동준 개발자의 고민: 교육 경험 자산화의 어려움, TTS(Text-to-Speech)를 활용하여 수다를 떨면 자동으로 문서화하고 에센스를 정돈하는 에이전트 개발 시도. - 조쉬의 사례: 노션(Notion) AI 활용 (Zoom/Google Meet 녹음 전사화, 투두리스트 자동 생성), 슬랙(Slack) 봇을 통한 회의록 전사 및 투두리스트 개인 워크스페이스 박기. - 실시간으로 데이터를 저장하고 LLM으로 대응하는 시스템 구축의 중요성 강조. 45:10 - 47:00: 마무리: 핵심 정리 및 최종 메시지 - 조쉬의 정리: "자산화를 위해 에센스를 가장 중요시하라. 어떻게 하면 구체화할 수 있을까 생각하게 됐다." Claude Skills/Agent 활용하여 컨벤션 문서(코드/디자인 가이드라인) 업그레이드 계획. - 임동준 개발자의 정리: "자산화 자체를 에이전틱(Agentic)하게 만들어 AI가 자산화를 더 잘하게끔 하는 시스템 구축"의 중요성 깨달음. - 임동준 개발자의 최종 메시지: "항상 프리프롬프팅을 해보자. (엔트로픽 가이드라인) 3단계 (명확한 성공 기준 정의, 경험적으로 테스트할 수 있는 환경, 개선하고 싶은 꽤 괜찮은 첫 번째 초안 프롬프트)를 기억하고 적용하자." 💡 추천 9/10 | AI 기술을 실제 현업에 적용하여 생산성을 높이려는 기업의 경영진, 리더, 팀장 개발, 디자인, 마케팅 등 AI 활용이 필수적인 직무에 종사하는 실무자 및 전문가 조직 내 AI 역량 강화 및 지식 자산화를 고민하는 HR 및 교육 담당자 LLM 기반 에이전트(Agent) 및 시스템 구축에 관심 있는 기술 관리자 및 개발자 AI 시대에 자신의 전문성을 어떻게 발전시켜 나갈지 고민하는 모든 직장인 이 영상은 AI 시대를 맞이하여 기업이 생산성과 전문성을 극대화하기 위한 핵심 방법론인 '자산화(Assetization)'의 본질과 구체적인 전략을 매우 심도 있게 다룹니다. 특히 '에센스 추출'이라는 독창적인 접근 방식을 디자인과 개발 사례에 적용하여 명확한 인사이트를 제공하며, Kent Beck과 같은 대가의 철학까지 아우르며 트렌드를 선도하는 전략적 가치를 제시합니다.

889857시간 전

코

코난쌤 conanssam

"이제 휴대폰에서 한달에 3달러로 클로드코드 쓰세요(진짜임) | 클로드코드 GLM 연동, 휴대폰 연동 방법

클로드 코드(Claude Code)의 높은 구독 비용을 절감하면서, GLM(General Large Model) 서비스 연동을 통해 기능을 확장하고, 심지어 휴대폰에서도 AI 코딩 및 지식 관리를 효율적으로 수행할 수 있는 방법은 무엇인가? Z.ai의 저렴한 GLM API를 클로드 코드에 연동하고, 테일스케일(Tailscale) 및 터미우스(Termius)와 같은 도구를 활용하여 PC/Mac에 설치된 클로드 코드를 휴대폰에서 원격 제어함으로써, 고급 AI 기능을 훨씬 저렴하고 유연하게 사용할 수 있습니다. 클로드 코드와 GLM을 연동하고 휴대폰에서 원격 사용하는 메커니즘은 무엇인가? • 포인트 1: **Z.ai GLM 서비스 연동을 통한 비용 절감 및 용량 확장**: Z.ai에서 제공하는 GLM 모델의 API를 클로드 코드에 등록하여 사용합니다. 이 서비스는 클로드 프로(Claude Pro) 대비 최대 60배에 달하는 토큰 용량을 훨씬 저렴한 가격(예: 월 3달러부터)에 제공하여, 고급 AI 기능 사용 비용을 대폭 절감합니다. GLM은 클로드의 API와 호환되도록 설계되어 기존 클로드 코드 환경에 쉽게 통합됩니다. • 포인트 2: **환경 변수 설정 및 스위처 스크립트 활용**: 클로드 코드에서 GLM API를 호출할 수 있도록 환경 변수 설정을 진행합니다. 복잡한 수동 설정을 간소화하기 위해, 엔트로픽(Anthropic)의 순수 클로드 모드와 Z.ai GLM 모드를 `claude` 및 `claude --glm` 명령어를 통해 쉽게 전환할 수 있는 '클로드 GLM 스위처(Claude GLM Switcher)' 스크립트를 적용합니다. 이 스크립트는 API 키 관리 및 호출 경로 설정을 자동화합니다. • 포인트 3: **테일스케일과 터미널 앱을 이용한 휴대폰 원격 접속**: PC/Mac에 설치된 클로드 코드를 휴대폰에서 원격으로 제어하기 위해 VPN 솔루션인 테일스케일(Tailscale)을 PC/Mac과 휴대폰에 설치하여 동일 계정으로 연동합니다. 이는 두 장치 간의 안전한 사설 네트워크를 구축하며, PC/Mac의 '원격 로그인(Remote Login)'(SSH) 기능을 활성화합니다. 이후 휴대폰의 터미널 앱(예: Termius)을 통해 PC/Mac의 IP 주소와 사용자 정보로 SSH 접속하여, CLI 환경에서 직접 클로드 코드 명령어를 실행하고 미리 정의된 '스킬(Skills)'을 활용할 수 있습니다. 이 영상은 클로드 코드(Claude Code) 사용자들이 직면하는 높은 구독 비용 문제에 대한 혁신적인 해결책을 제시합니다. 기존의 고가 클로드 코드 맥스(Claude Code Max) 구독 없이도, Z.ai에서 제공하는 GLM(General Large Model) API를 클로드 코드 프로(Claude Code Pro)와 결합하여 유사하거나 더 높은 효율성을 훨씬 저렴한 비용으로 달성하는 방법을 상세히 안내합니다. 영상은 특히 PC/Mac 환경에서의 GLM 연동 및 모드 전환 스크립트 설정 방법을 깊이 있게 다루며, 나아가 이 강력한 AI 코딩 환경을 휴대폰에서 원격으로 활용할 수 있는 실용적인 방법까지 선보입니다. 테일스케일(Tailscale) VPN과 터미널 앱(Termius)을 이용한 원격 접속을 통해, 언제 어디서든 클로드 코드를 활용하여 유튜브 영상 요약 및 PPT 변환, 웹 문서 요약 및 옵시디언(Obsidian) 지식 관리 등 다양한 작업을 수행하는 과정을 시연합니다. 궁극적으로 이 영상은 고급 AI 기능을 저비용으로 극대화하고, 모바일 환경에서도 끊김 없는 생산성을 유지하려는 사용자들에게 필수적인 가이드라인을 제공하며, 스마트한 AI 활용의 새로운 가능성을 열어줍니다. 00:00 - 00:20 영상 시작 및 핵심 소개: 코난쌤은 클로드 코드 맥스(Claude Code Max) 구독 중단 후, 월 3달러로 GLM(General Large Model)을 연동하여 클로드 코드(Claude Code)를 휴대폰에서 사용하는 방법을 소개합니다. 휴대폰에서 클로드 코드를 GLM 모드로 실행하여 옵시디언(Obsidian) 문서 정리 및 저장, 최적화 모델 소개 등 작업이 실시간으로 동기화되는 모습을 보여줍니다. 00:20 - 01:00 클로드 코드 사용 경험과 대안의 필요성: 연사(코난쌤)는 개인적으로 클로드 코드 맥스 구독을 끊고 프로 계정만 사용 중이며, 오늘 소개할 방법을 통해 맥스 못지않은 효율을 얻을 수 있다고 설명합니다. 비용 절감과 함께 스마트폰에서도 코딩이 가능해진 새로운 AI 활용법을 제시하며 기대감을 높입니다. 01:00 - 01:45 휴대폰에서 클로드 코드 시연 (YouTube to PPT): 휴대폰 화면에서 클로드 코드를 실행하여 유튜브(YouTube) 영상 링크를 넣고 'PPT로 만들어 주세요. 사진 포함'이라는 명령으로 `YTtoPPT 스킬(Skill)`을 구동합니다. 영상이 PPT 슬라이드로 자동으로 변환되는 과정을 보여주며 클로드 코드의 모바일 활용 가능성을 입증합니다. 01:45 - 03:00 Z.ai GLM 서비스 소개 및 요금제 분석: Z.ai AI 서비스는 클로드 오퍼스 4.5(Claude Opus 4.5)와 유사한 성능을 내세우며, 월 3달러(라이트), 15달러(프로), 30달러(맥스)의 세 가지 요금제를 제공합니다. 각 요금제가 클로드 프로(Claude Pro) 대비 3배, 15배, 60배의 훨씬 많은 용량을 제공하며, 연간 구독 시 더 큰 할인이 적용(연사 기준 $23-$26 결제)됨을 강조합니다. 크레딧 시스템을 통해 추가 결제 시 할인을 받을 수 있는 점도 언급합니다. 03:00 - 04:00 GLM 사용량 및 토큰 관리: 가장 낮은 월 3달러 요금제 기준으로 한 달에 웹 검색 및 툴 호출 100회, 5시간 쿼터가 제공되며, 토큰 소모량이 예상보다 적어 거의 고갈되지 않는다고 설명합니다. 5시간마다 1,200만 토큰이 충전되어 하루 4천만 토큰 이상 사용 가능하며, 피크 시간에도 사용에 문제가 없음을 실제 그래프로 보여줍니다. 04:00 - 04:45 클로드 코드와 GLM 연동 원리: 클로드 코드에서 구독 모드와 API 모드를 모두 지원하며, GLM 서비스가 클로드 코드와 동일한 API 코를 제공하여 연동이 가능함을 설명합니다. 04:45 - 05:30 PC/Mac 환경에서의 GLM 연동 준비 (설치 및 구독): 클로드 코드 기본 설치 명령어를 안내하고, GLM 서비스 구독을 권장하며, 연사 링크를 통한 10% 추가 할인 혜택을 소개합니다. 환경 변수 설정의 복잡성을 언급하며 다음 단계에서 스크립트를 통한 간편 설정을 예고합니다. 05:30 - 06:30 클로드 GLM 스위처 스크립트 소개: 엔트로픽(Anthropic)의 순수 클로드와 Z.ai의 GLM 모드를 `--glm` 플래그를 통해 손쉽게 전환할 수 있는 '클로드 GLM 스위처(Claude GLM Switcher)' 스크립트를 직접 개발했음을 밝힙니다. 06:30 - 07:30 Mac에서의 스크립트 설정 방법: `~/.zshrc` 파일에 스크립트 내용을 복사하여 붙여 넣고, GLM API 키를 입력하는 위치를 안내합니다. GLM API를 래핑(wrapping)하는 함수의 역할을 설명합니다. 07:30 - 08:30 스크립트 실행 및 클로드 코드 재설치: 배포된 스크립트를 안티그리프티(Antigravity)에서 열어 실행하는 과정을 보여줍니다. 오류 발생 시 `npm install -g claude-code` 명령으로 클로드 코드를 재설치해야 할 수 있음을 언급하고, API 키 입력 프롬프트에 키를 넣어주는 과정을 시연합니다. 08:30 - 09:30 GLM/엔트로픽 모드 전환 확인: `claude` 명령으로 엔트로픽 모드, `claude --glm` 명령으로 GLM 모드 실행을 확인합니다. `claude status` 명령으로 API 키 아래의 `base_url` (Z.ai 여부)을 확인하여 현재 활성화된 모드를 파악하는 방법을 설명합니다. Windows 환경 설정에 대한 언급과 함께 'install-claude-glm.sh'라는 통합 설치 스크립트 제공을 예고합니다. 09:30 - 10:15 휴대폰에서 클로드 코드 설정 준비 (PC 연결): PC와 휴대폰을 VPN을 이용하여 연결할 것임을 밝히며, 테일스케일(Tailscale) 도구 사용을 소개합니다. 10:15 - 11:15 PC/Mac 준비 (Tailscale 및 원격 로그인 설정): 테일스케일을 PC와 휴대폰에 설치하고 동일 계정으로 연결하는 방법을 설명합니다. 이는 서버 구축 작업을 대체하는 VPN 기능입니다. Mac의 '시스템 설정 > 공유 > 원격 로그인(Remote Login)' 활성화 및 잠자기 방지 설정이 필요함을 강조합니다. Windows 사용자의 경우 오픈 SSH 서버(OpenSSH Server) 설치를 언급합니다. 11:15 - 12:15 스마트폰 준비 (Termius 및 PC 연결): 휴대폰에 터미널 앱 '터미우스(Termius)'를 설치하고, PC의 테일스케일 IP 주소를 사용하여 연결을 시도합니다. PC의 사용자 이름(Mac의 '이 Mac에 관하여'에서 확인)과 비밀번호를 입력하여 접속하는 과정을 보여줍니다. 12:15 - 13:30 터미우스에서 클로드 코드 사용 환경 구축: 터미널 창에 접속 후, `mkdir` 명령어로 새로운 폴더를 생성하고 `cd` 명령어로 해당 폴더로 이동하는 방법을 안내합니다. 명령어를 모르는 경우 Termius의 AI 기능을 통해 명령어 도움을 받을 수 있음을 보여줍니다. 13:30 - 14:00 휴대폰에서 클로드 코드 실행 확인: 휴대폰 터미널에서 `claude` 명령을 입력하여 엔트로픽 모드로 클로드 코드가 정상적으로 실행되는 것을 확인합니다. 14:00 - 15:00 휴대폰에서 GLM 모드와 'YTtoPPT' 스킬 시연: 카메라를 전환하여 휴대폰 화면에서 `claude --glm` 명령으로 GLM 모드를 실행하는 모습을 보여줍니다. 미리 저장된 `YTtoPPT 스킬`을 불러와 유튜브 링크와 '이미지도 빼먹지 마'라는 추가 프롬프트를 함께 입력하여, 유튜브 영상을 파워포인트로 변환하는 과정을 실시간으로 보여줍니다. 15:00 - 16:00 휴대폰에서 GLM 모드와 'Obsidian MCP' 스킬 시연: `claude --glm` 실행 후 '바이패스 퍼미션(bypass permission)'을 사용하여 허깅페이스(Hugging Face) 블로그 아티클 링크를 옵시디언 MCP(Obsidian MCP) 스킬에 입력합니다. '옵시디언 MCP를 사용해 줘. 문서를 정리하고 저장해 줘.'라는 음성 프롬프트를 통해 웹 페이지 내용을 가져와 옵시디언 볼트(Obsidian Vault)에 저장하는 과정을 보여줍니다. 16:00 - 17:00 옵시디언 MCP의 동작 원리 설명: 옵시디언 MCP가 크롬 데브툴(Chrome DevTools)을 이용해 웹 페이지를 가져와 콘텐츠를 확인하고, 연사의 '코난쌤 볼트'에 저장하는 방식을 설명합니다. 잉크 노트(Ink Note)와 옵시디언 연동을 통해 저장된 문서를 쉽게 확인할 수 있음을 언급합니다. 17:00 - 18:00 옵시디언에 저장된 문서 확인 및 동기화: PC의 옵시디언에서 '마이크로소프트 옵티마인드(Microsoft Optimind) 최적화 모델 소개'라는 제목으로 저장된 문서가 실시간으로 동기화되어 깔끔하게 정리된 형태로 확인되는 것을 보여주며, 휴대폰에서의 작업이 PC로 즉시 연동되는 효율성을 강조합니다. 18:00 - 18:30 활용성 요약: 휴대폰에서 링크를 던져주면 클로드 코드가 알아서 내용을 정리하고 옵시디언으로 지식 관리를 할 수 있으며, `YTtoPPT` 스킬처럼 다양한 스킬을 활용하여 지식 관리 및 콘텐츠 정리가 용이해졌음을 다시 한번 강조합니다. 18:30 - 19:00 마무리: 클로드 코드 GLM 연동 및 휴대폰 사용법이라는 두 가지 핵심 내용을 요약하며, 시청자들에게 직접 따라 해 볼 것을 권장하고 질문에 대한 답변을 약속하며 영상을 마칩니다. 💡 추천 9/10 | 클로드 코드(Claude Code) 또는 유사 AI 코딩 도구 사용자, 높은 AI 구독 비용에 부담을 느끼는 사용자, 효율적인 지식 관리(예: 옵시디언 사용자) 및 콘텐츠 생성(예: 유튜브 요약, PPT 변환)에 관심 있는 전문가, 개발자, 학생, 모바일 환경에서 AI 생산성을 극대화하고 싶은 테크 얼리어답터 이 영상은 클로드 코드(Claude Code)의 사용성을 혁신적으로 확장하고 비용 효율성을 극대화하는 방법을 명확하고 실용적으로 제시합니다. 특히 Z.ai GLM 서비스 연동을 통한 대폭적인 비용 절감과 함께, 휴대폰에서의 원격 AI 코딩 및 지식 관리 솔루션은 현대 사용자의 니즈를 정확히 충족시키며 트렌드를 선도하는 유용한 정보를 제공합니다. 상세한 설정 가이드와 실제 시연을 통해 복잡한 기술을 쉽게 이해하고 적용할 수 있도록 돕는 점이 매우 인상 깊습니다.

420399시간 전

프

프리랜서 개발자

99%가 모르는 구글의 AI 활용법: 프롬프트 엔지니어링 마스터 가이드

AI/LLM을 효율적으로 활용하기 위한 '프롬프트 엔지니어링(Prompt Engineering)'은 무엇이며, 어떻게 마스터할 수 있는가? 프롬프트 엔지니어링은 AI 모델로부터 원하는 결과물을 얻기 위해 명확하고 체계적인 지시를 내리는 기술이며, 구글이 제시하는 5가지 핵심 원칙(Task, Context, References, Evaluate, Iterate)과 고급 기술들을 통해 마스터할 수 있습니다. 구글이 제시하는 프롬프트 엔지니어링의 핵심 원칙과 고급 활용 메커니즘은 무엇인가? • **핵심 원칙 (T.C.R.E.I. 프레임워크):** - **Task (과제):** AI가 수행할 정확한 결과물을 정의합니다. 페르소나(Persona) 할당 및 형식(Format) 지정을 통해 더욱 강력하게 만들 수 있습니다. - **Context (맥락):** 모델을 조종하는 배경 데이터를 풍부하게 제공하여 AI가 추측할 부분을 최소화합니다. - **References (참조):** AI에게 목표를 보여주는 예시(텍스트, 이미지 등)를 제공하여 모호한 지시를 구체적인 목표로 전환합니다. - **Evaluate (평가):** AI의 결과물이 과제와 일치하는지, 올바른 톤을 유지하는지 등 체계적으로 검증하여 목표 달성 여부를 확인합니다. - **Iterate (반복):** 프롬프트는 직선이 아닌 루프(요청-확인-조정-재요청)이며, 프레임워크 재방문, 간단한 문장으로 나누기, 유사한 작업 사용, 제약 조건 추가 등의 방법으로 프롬프트를 개선합니다. • **AI 모델의 구조적 결함 및 해결책:** - **환각 (Hallucinations):** AI가 자신감 있게 거짓 정보를 지어내는 현상으로, '인텔리전스(intelligence)' 단어의 'e' 개수와 같은 간단한 논리 문제에서 발생할 수 있습니다. - **편향 (Bias):** 학습 데이터에 내재된 인간의 성별, 인종적, 문화적 편견을 AI가 흡수하여 나타내는 현상입니다. - **해결책: Human in the Loop (인간 개입):** AI를 맹목적으로 신뢰하지 않고, 인간이 안전망으로서 최종 결과물에 대한 책임을 지고 검증하며 의문을 제기해야 합니다. • **고급 프롬프트 엔지니어링 기술:** - **멀티모달 프롬프트 (Multimodal Prompts):** 텍스트 외에 이미지, 오디오, 비디오 등 다양한 유형의 데이터를 입력으로 활용하여 AI가 더 풍부한 정보를 기반으로 추론하고 작업을 수행하도록 합니다 (예: Gemini). - **프롬프트 체이닝 (Prompt Chaining):** 하나의 프롬프트 출력을 다음 프롬프트의 입력으로 사용하여 복잡한 프로젝트를 여러 단계로 나누어 AI와 함께 진행합니다. - **체인 오브 소트 프롬프트 (Chain-of-Thought Prompting):** AI에게 추론 과정을 단계별로 설명하도록 요청하여 논리적 결함을 즉시 발견하고 안내할 수 있도록 합니다. - **트리 오브 소트 프롬프트 (Tree-of-Thought Prompting):** AI가 동시에 여러 추론 경로를 탐색하여 창의적인 프로젝트나 전략적 결정과 같은 복잡한 문제에 대해 다양한 옵션을 생성하고 평가할 수 있도록 합니다. - **AI 에이전트 (AI Agents):** 특정 '가치 있는 작업'을 수행하도록 설계된 전문화된 페르소나로, 시뮬레이션 에이전트(연습 파트너)와 전문가 피드백 에이전트(개인 컨설턴트) 두 가지 유형이 있으며, 페르소나, 컨텍스트, 상호 작용, 중단 문구, 요약 규칙을 정의하여 구축합니다. - **메타프롬프팅 (Metaprompting):** AI에게 자신의 프롬프트(Prompt)를 개선하는 방법에 대해 질문하여 더 구체적이거나 필요한 컨텍스트를 파악하는 궁극적인 활용법입니다. 이 영상은 구글의 6시간 분량 프롬프트 엔지니어링(Prompt Engineering) 코스의 핵심 내용을 12분 안에 압축하여 제공하는 마스터 가이드입니다. 효과적인 AI 활용을 위한 기본적인 접근 방식부터 고급 전략까지 포괄적으로 다루며, 시청자가 AI 모델(예: Gemini, GPT)로부터 원하는 결과를 얻기 위해 어떻게 프롬프트를 설계하고 개선해야 하는지에 대한 실용적인 지침을 제공합니다. 영상은 구글이 제시하는 5가지 핵심 원칙인 Task(과제), Context(맥락), References(참조), Evaluate(평가), Iterate(반복)를 중심으로 프롬프트 엔지니어링의 기본을 설명합니다. 또한, AI 모델의 한계(환각, 편향)를 인지하고 'Human in the Loop' 개념을 통해 이를 극복하는 방법과 멀티모달 프롬프트, 프롬프트 체이닝, 체인 오브 소트, 트리 오브 소트, AI 에이전트, 메타프롬프팅과 같은 고급 기술들을 통해 AI 활용 능력을 극대화하는 방법을 안내합니다. 00:00 영상 개요 및 구글 코스 소개 - 구글의 6시간 프롬프트 엔지니어링 코스를 요약, 12분 안에 전체 시스템 마스터 목표 - 구글 공식 서티피케이트(Certificate) 링크는 설명란에 제공 - 핵심은 AI 모델이 실제로 어떻게 생각하는지 이해하는 것 00:37 구글의 5가지 핵심 원칙 (T.C.R.E.I. 프레임워크) - Task (과제), Context (맥락), References (참조), Evaluate (평가), Iterate (반복) 00:46 1. Task (과제) - AI가 무엇을 하길 원하는지에 대한 정확한 결과물 정의 (일반적 주제 X) - 나쁜 Task 예: '이메일 도와줘' / 좋은 Task 예: '체육관 직원에게 일정 변경을 알리는 이메일을 쓰도록 문장을 재구성해 줘' - **Task 강화 요소:** - **페르소나 (Persona):** AI에게 전문가처럼 행동하도록 지시하여 특정 어휘와 논리 체계에 접근하게 함 (예: 물리 치료사처럼 행동해) - **형식 (Format):** 결과물의 형식을 정의하여 AI가 생각을 정리하도록 강제함 (예: 글머리 기호 목록, 마크다운 표, 파이썬 스니펫). 02:27 2. Context (맥락) - 모델을 조종하는 배경 데이터 제공. 정보를 많이 제공할수록 AI의 추측 최소화 - 예: 일반적인 랜딩 페이지 문구 요청 vs. 프리랜서 디자이너용 프로젝트 관리 도구 설명 (타겟 사용자, 제품 특징, 톤 포함) - 대부분의 사람들이 Context를 간과하는 문제점 지적 03:46 3. References (참조) - AI에게 목표를 보여주는 예시. 특정 분위기나 구조 포착 시 유용 - 예: 특정 브랜드 목소리에 맞는 제품 설명 작성 시, 성공적인 소셜 미디어 게시물 분석 및 적용 시 - 모호한 지시를 구체적인 목표로 바꿔 모델이 스타일을 추측하는 대신 일치시키도록 강제 04:54 4. Evaluate (평가) - 결과물이 목표를 달성했는지 확인. 체계적인 평가 필요 - 과제 일치 여부, 올바른 톤 유지 여부, 정확한 데이터 기반 여부 적극 검증 - 평가 후 수정이 필요하면 다음 단계인 Iterate로 넘어감 05:25 5. Iterate (반복) - 프롬프트는 직선이 아닌 루프(요청-확인-조정-다시 요청) 과정 - **망가진 프롬프팅 수정 방법:** - **프레임워크 재방문:** Task, Context, References 등 처음 놓친 빈칸 확인 및 채우기 - **더 간단한 문장으로 나누기:** 방대한 지시 사항을 여러 문장으로 쪼개서 명확한 구조로 제공 (예: Q1 전략, Z세대 타겟, 예산, KPI 각각 분리) - **유사한 작업 사용:** 직접적인 접근 방식 실패 시 다른 각도로 시도 (예: 사업 제안서 대신 파트너십 설득력 있는 주장 작성 요청) - **제약 조건 (Constraints) 추가:** 요구 사항을 엄격하게 제한하여 AI의 창의성을 강제하고 아이디어를 구체화 (예: 90초 미만, 하나의 팁, 질문으로 시작하는 비디오 아이디어) 07:11 멀티모달 프롬프트 (Multimodal Prompts) - 텍스트를 넘어 이미지, 오디오, 비디오를 기본적으로 처리하는 모델 (예: Gemini) 활용법 - 예: 웹사이트 스크린샷 업로드 후 디자인 분석 및 개선 사항 제안 요청, 오디오 파일 업로드 후 곡 분위기 설명 및 편곡 방향 제안 요청 - 프레임워크는 동일하며, 텍스트 대신 고해상도 시각/오디오 레퍼런스 사용 08:00 AI 모델의 구조적 결함: 환각 (Hallucinations)과 편향 (Bias) - **환각 (Hallucinations):** AI가 자신감 있게 보이지만 완전히 거짓 정보를 지어내는 현상 (예: 'intelligence' 단어의 'e' 개수 오류) - **편향 (Bias):** 개방된 인터넷 학습으로 인해 인간의 성별, 인종적, 문화적 편견을 흡수하는 현상 - **구글의 해결책: Human in the Loop (인간 개입):** 인간이 안전망으로서 최종 결과물에 대한 책임이 있으며, AI를 맹목적으로 믿지 않고 검증하며 모든 가정에 의문을 제기해야 함 09:00 실용적인 AI 적용 사례 - 프리랜서 컨설턴트의 온보딩 이메일 자동화 마스터 프롬프팅 예시 (페르소나, 타임라인, 커뮤니케이션, 예상 내용, 단어 수, 톤 지정) 09:44 고급 프롬프트 기술: 프롬프트 체이닝 (Prompt Chaining) - 한 프롬프트의 출력을 다음 입력으로 사용하는 기술 (복잡성 층층이 쌓기) - 예: 인디 게임 팟캐스트 기획 (1. 이름 생성 -> 2. 태그라인 생성 -> 3. 4주 출시 계획 수립) - 거대한 프로젝트를 단일 요청에 억지로 넣는 대신 논리적인 순서로 AI를 안내 10:48 고급 프롬프트 기술: 체인 오브 소트 프롬프트 (Chain-of-Thought Prompting) - AI에게 추론 과정을 단계별로 설명하도록 요청하여 결함 있는 논리 즉시 발견 - 예: 앱 가격 모델 결정 시 사용자 심리, 수익 지속 가능성, 경쟁사 가격을 고려한 단계별 추론 과정 설명 요청 11:25 고급 프롬프트 기술: 트리 오브 소트 프롬프트 (Tree-of-Thought Prompting) - 동시에 여러 추론 경로를 탐색하여 복잡한 문제 해결에 완벽 (창의적 프로젝트, 전략적 결정) - 예: 모바일 앱 온보딩 흐름 설계 시 속도, 교육, 개인화에 초점을 맞춘 3가지 다른 접근 방식 생성 및 사용자 경험, 잠재적 이탈 지점 설명 요청 12:00 AI 에이전트 (AI Agents) - 구글이 한 모듈을 할애할 만큼 중요하게 다루는 개념 - 특정 가치 있는 작업을 수행하도록 설계된 전문화된 페르소나 - **두 가지 강력한 유형:** - **시뮬레이션 에이전트 (Simulation Agent):** 연습 파트너 역할. 라이브 시나리오(예: 중요한 세일즈 통화, 인터뷰) 실행 - 예: 수석 채용 관리자 페르소나로 프로젝트 매니저 역할 행동 면접 질문 요청 및 피드백 받기 - **전문가 피드백 에이전트 (Expert Feedback Agent):** 개인 컨설턴트 역할 - 예: 15년 경력 영업 전문가 페르소나로 콜드 이메일 템플릿의 제목 효율성, 가치 명확성, 행동 유도 약점 비평 및 개선 제안 요청 - **AI 에이전트 구축 청사진:** 페르소나 할당 → 컨텍스트 주입 → 상호 작용 정의 → 중단 문구 설정 및 특정 문구 입력 시 최고의 추천 사항 요약 지시 14:26 고급 프롬프트 기술: 메타프롬프팅 (Metaprompting) - 궁극적인 치트키: 막힐 때마다 AI를 사용하여 자신의 프롬프트를 계산하는 것 - 예: '이 프롬프팅을 더 구체적으로 만들려면 어떻게 해야 해?' 또는 '더 나은 결과를 위해 내가 놓친 컨텍스트는 뭐야?' - AI가 부조종사(co-pilot) 역할로 프롬프트에 대한 프롬프트 15:02 결론 및 요약 - 구글의 6시간 코스를 압축한 실용적인 가이드 - T.C.R.E.I. 흐름 기억: Task 정의, Context 설정, References 제공, Evaluate 후 Iterate - 이 루프가 AI를 불평하는 사람들과 시간을 절약하는 사람들의 차이 - 다음에 Gemini나 GPT를 사용할 때 한 문장으로 추측하는 것을 멈추고 층층이 프롬프트 쌓아 올리기 - 더 깊이 들어가 구글 서티피케이트 취득을 원하면 설명란 링크 참조 💡 추천 9/10 | AI 챗봇(ChatGPT, Gemini 등)을 활용하여 생산성을 높이고 싶은 개인 및 비즈니스 종사자, 프리랜서, 개발자, 마케터, 콘텐츠 크리에이터, 프롬프트 엔지니어링에 관심 있는 모든 사용자 구글의 방대한 프롬프트 엔지니어링 강의를 12분 만에 핵심만 뽑아 체계적으로 전달하는, 매우 유익하고 실용적인 영상입니다. 기본 원칙부터 고급 활용법, AI의 한계점과 해결책까지 폭넓게 다루어 AI 활용 능력을 한 단계 높이고자 하는 모든 이에게 필수적입니다.

142910시간 전

콘텐츠가 없습니다

D

designbywani

@designbywani디자이너가 코딩을 배우려는 이유는 다음과 같습니다. 1. 솔직히 개발을 한 번쯤은 제대로 배워보고 싶었습니다. 2. 저는 항상 개념을 알아야 마음이 놓이는 편입니다. 3. 개발자 코파운더에게 조금이라도 도움이 되고 싶었습니다. 4. 개념을 알고 AI를 쓰면 질문의 질이 완전히 달라질 거라 생각했습니다. 5. 올해 앱을 하나 더 내고 싶은데, 기획은 끝났고 팀 캐파가 부족합니다. 6. 지금 서비스도 개발할 게 많아서, 제가 조금이라도 도움이되고 싶었습니다. 7. 아직은 할 만한데, 곧 벽을 느낄 것 같고 개발자분들이 더 존경스러워졌습니다. AI가 더 발전하기전에 AI를 더 잘 쓰기 위해서라도 지금은 직접 부딪혀보는 게 맞다고 생각했습니다. 저 할 수 있겠죠..?

22시간 전

00

J

joshproductletter

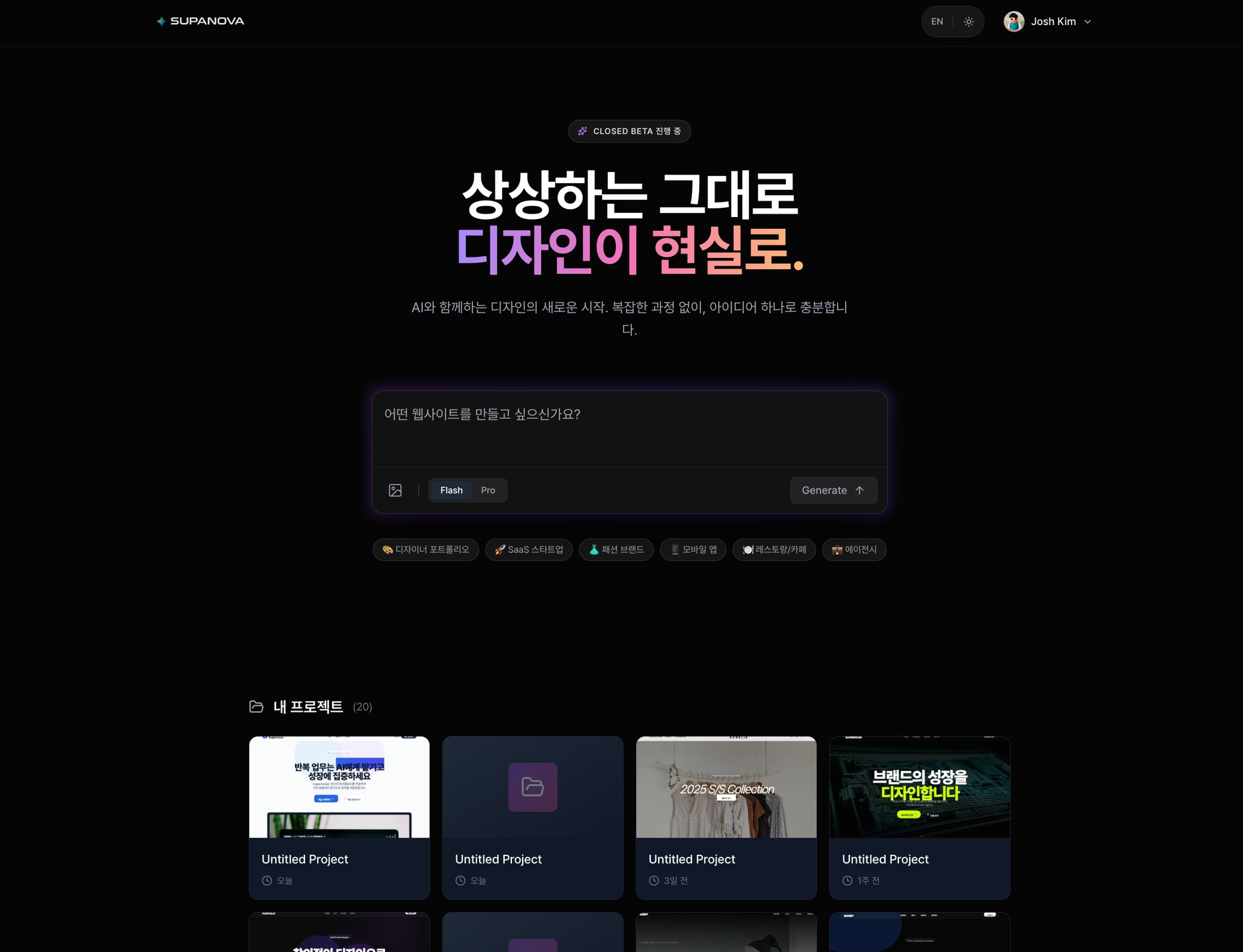

@joshproductletter바이브 디자인 SaaS, 'Supanova'를 오늘 베타 런칭했습니다. 전 세계 있는 수많은 바이브코더와 사업자를 위한 '멋진 디자인 랜딩페이지' 제품입니다. 12월에 런칭하겠다고 해놓고 조금 늦어진 이유는, 탄탄한 인프라를 갖추고자 공동창업자를 구했기 때문입니다. @pauljo.dev 바울님은, 제가 작년 트레바리를 진행하며 만난, 보기 드문 인성을 보유한 프로 개발자이십니다. 저희는 2인 팀으로, 글로벌 시장에 진출하고 큰 꿈을 향해 의기투합하기로 했어요. 월요일부터 본격적인 런칭과 사업을 출발하며, 26년 많은 기대 부탁드리겠습니다. :)

22시간 전

00

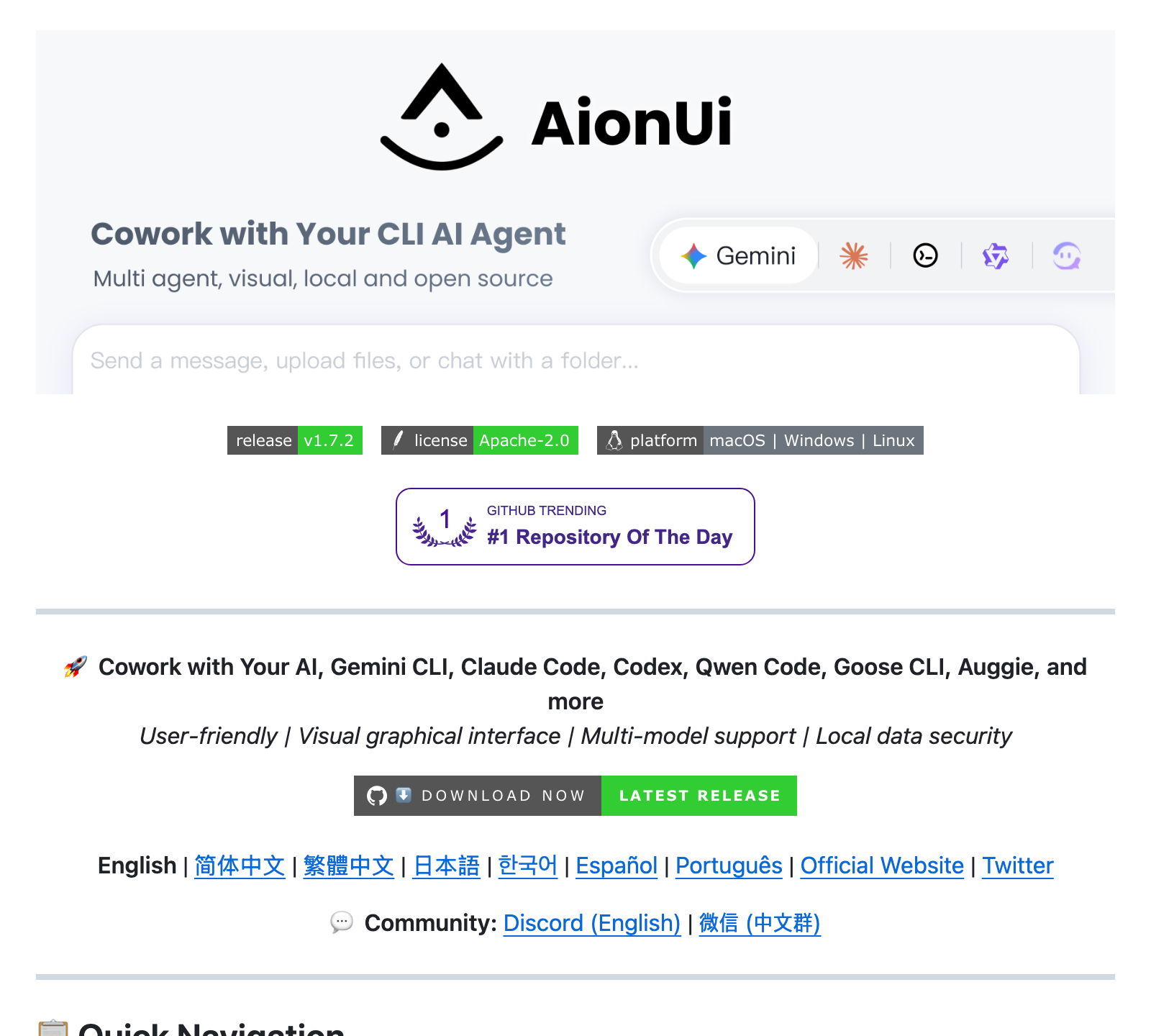

AI CLI 도구를 위한 통합 그래픽 인터페이스

- Gemini CLI 내장 - 설치 즉시 사용 가능

- 9가지 이상 파일 형식 실시간 미리보기

- 스마트 파일 관리 및 AI 협업

💡 Claude Cowork보다 나은 점: 여러 AI CLI 도구를 하나의 GUI에서 통합 관리

TypeScript7.0K533#1

Apache-2.0

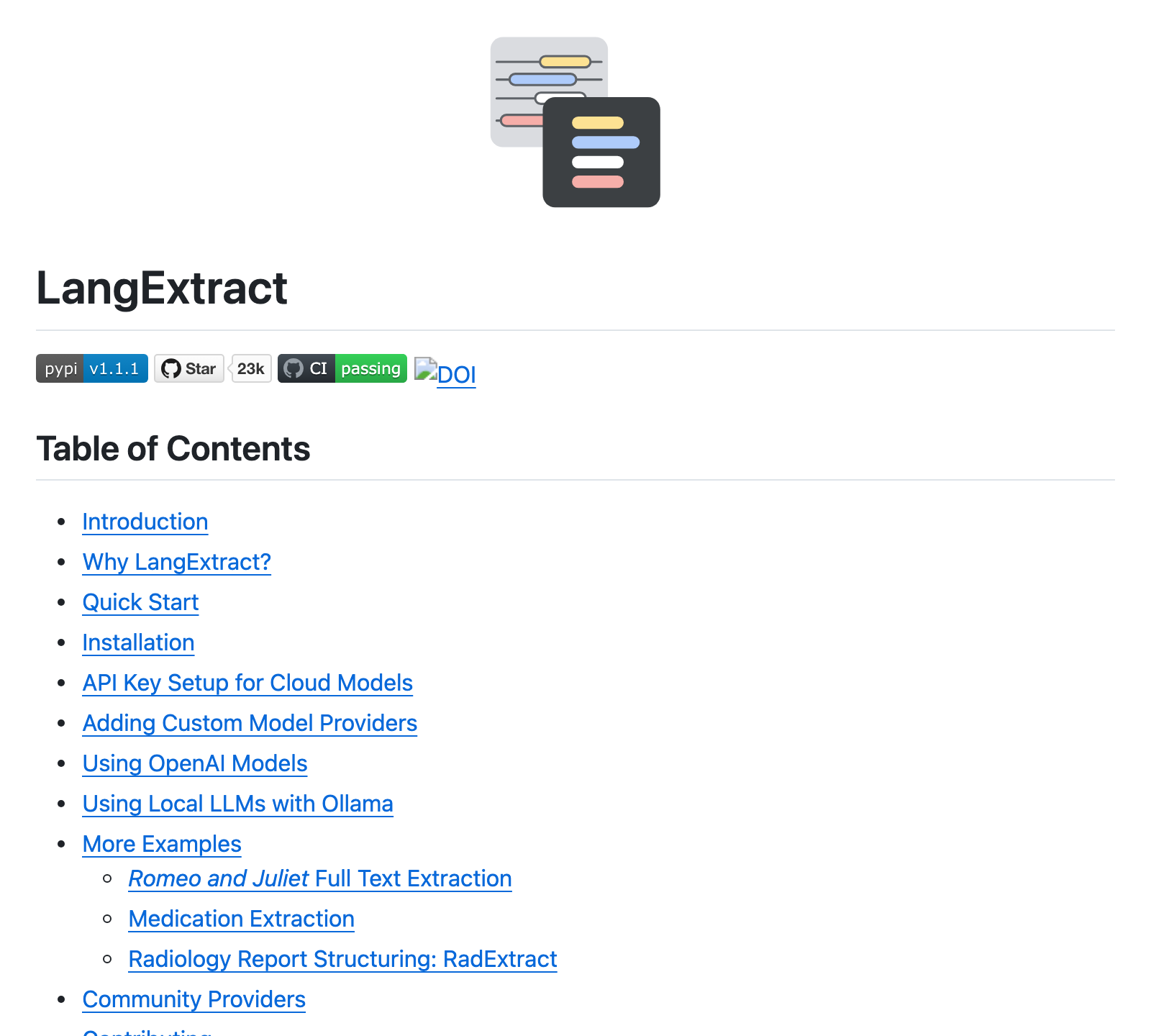

LLM 기반 정형 정보 추출 라이브러리

- 정확한 소스 그라운딩 - 원본 텍스트 위치 매핑

- 신뢰할 수 있는 구조화된 출력

- 긴 문서 최적화 - 청킹, 병렬 처리, 다중 패스

💡 LangChain보다 나은 점: 추출 결과를 원본 텍스트에 정확히 매핑 + 인터랙티브 시각화

Python22.8K1.6K#1

Apache-2.0

토크나이저 없는 컨텍스트 인식 음성 합성 엔진

- 토크나이저 없는 엔드투엔드 TTS

- 컨텍스트 인식 표현적 음성 생성

- 제로샷 보이스 클로닝

💡 XTTS보다 나은 점: 연속 공간에서 음성 생성 + 제로샷 보이스 클로닝

Python5.0K588#1

Apache-2.0

Claude AI로 Blender 3D 모델링을 자동화하는 MCP

- MCP를 통한 Claude-Blender 직접 상호작용

- 대화형 프롬프트 기반 3D 모델링

- 텍스트에서 AI 기반 씬 생성

💡 수동 3D 모델링보다 나은 점: 대화형 3D 생성을 위한 실시간 Claude-Blender 통합

Python15.7K1.5K#1

Unknown

Claude가 n8n 워크플로우를 만들어주는 MCP 서버

- 1,084개 n8n 노드 접근 (코어 + 커뮤니티)

- 노드 속성 99% 커버리지

- 노드 오퍼레이션 63.6% 커버리지

💡 n8n 수동 설정보다 나은 점: 1,084개 노드와 2,646개 실제 예시에 대한 AI 접근

TypeScript12.0K2.2K#1

MIT

구글이 만든 LLM 기반 구조화 데이터 추출기

- 클라우드 모델 통합 (OpenAI, Google AI)

- Ollama를 통한 로컬 LLM 지원

- 커스텀 모델 프로바이더 설정

💡 LangChain보다 나은 점: RadExtract로 의료/방사선 보고서 전문 추출

Python22.4K1.5K#1

Unknown

r/r/vibecoding에 게시됨 u/u/Educational-Ninja590

u/u/Educational-Ninja590

AI 코딩 중 막힐 때 어떻게 해야 하나요

막혔습니다... 바이브코딩을 시작한 지 얼마 안 됐고 코드를 직접 작성할 줄 모릅니다. 웹사이트, 이어 트레이닝 앱, 인터랙티브 오디오북 등을 만들었는데, 거의 항상 AI가 전체 프로그램을 파악하지 못하고 수정이 새로운 문제를 일으키는 지점에 도달합니다. 작은 수정 하나가 대규모 새 오류를 만들어냅니다. 현재 Anti-Gravity에서 Claude Opus와 Gemini 3 Pro를 사용 중입니다. 도움이 될 조언 부탁드립니다.

23시간 전

1

100% 추천r/r/vibecoding에 게시됨 u/u/Aye-caramba24

u/u/Aye-caramba24

바이브코딩 제대로 하는 4단계 가이드

바이브코딩을 할 거라면 더 나은 방법이 있습니다. 1단계: 제품 독트린 - 기능, 스택, 사용자 흐름을 담은 마스터 문서 생성. 2단계: 비주얼 우선 - 브랜딩 가이드를 사용해 기능 전에 UI 먼저 구축. 3단계: 갭 분석 - 추론 모델(Claude/o1)로 스펙 작성 후 IDE에 구현 지시. 4단계: 세일즈 - 사용자의 페인포인트에 맞는 콘텐츠 생성. 요약: 제품 문서와 브랜딩 가이드를 여권처럼 모든 빌드 과정에 가지고 다니세요.

23시간 전

0

100% 추천r/r/vibecoding에 게시됨 u/u/jpcaparas

u/u/jpcaparas

Claude Code 멀티세션 Ralph 워크플로우 가이드

지금 바로 시도해볼 수 있는 견고한 Ralph Wiggum 워크플로우입니다. Claude Code를 사용한 멀티세션 코딩 실용 가이드입니다. 다루는 내용: Anthropic의 2-에이전트 패턴(초기화 + 코딩 에이전트), progress.md와 피처 리스트를 활용한 파일 기반 상태 관리, 더 나은 스펙 생성을 위한 인터뷰 기법, Ralph CLI 설정 및 구성. 코드 예제와 다이어그램 포함 14분 분량의 글입니다.

1일 전

1

100% 추천카테고리별 탐색

관심 분야의 콘텐츠를 찾아보세요